امروزه ردپای تکنولوژیهای هوشمند را در همهجا میبینیم؛ از دستیارهای صوتی گرفته تا الگوریتمهای پیچیدهای که بازارهای مالی را تحلیل میکنند. اما این فناوری پیشرو، حاصل کار یک شبه نیست. تاریخچه هوش مصنوعی، داستانی جذاب و پرفراز و نشیب از رویاهای بزرگ، شکستهای تلخ موسوم به زمستان هوش مصنوعی و جهشهای تکنولوژیک خیرهکننده است.

برای درک عمیق این سیر تکاملی، باید ابتدا بدانیم که دقیقاً ماهیت و تعریف هوش مصنوعی چیست و چگونه از مفاهیم انتزاعی ریاضی به ابزارهای کاربردی امروزی تبدیل شده است. شناخت ریشههای تاریخی و فلسفی این علم، نه تنها دیدگاه ما را نسبت به تکنولوژی روشنتر میکند، بلکه زیربنایی اساسی برای علاقهمندانی است که قصد یادگیری هوش مصنوعی از صفر و ورود حرفهای به این حوزه را دارند؛ چرا که فهمیدن گذشته، کلید تسلط بر آینده و مسیر پیشروی این فناوری است.

تولد یک رویا (۱۹۵۰–۱۹۵۶): از آلن تورینگ تا کنفرانس دارتموث

اگر بخواهیم تاریخچه هوش مصنوعی را به دقت بررسی کنیم، باید به اوایل دهه ۱۹۵۰ بازگردیم؛ زمانی که دانشمندان و ریاضیدانان برای اولین بار جسارت این را پیدا کردند که بپرسند: «آیا ماشینها میتوانند فکر کنند؟». این دوران، نقطه عطف تبدیل داستانهای علمی-تخیلی به واقعیت علمی بود.

آلن تورینگ (۱۹۵۰)

همه چیز با مقاله انقلابی آلن تورینگ (Alan Turing)، ریاضیدان برجسته بریتانیایی، تحت عنوان «ماشینهای محاسباتی و هوش» آغاز شد. تورینگ که پدر علوم کامپیوتر مدرن محسوب میشود، معیاری برای سنجش هوشمندی ماشین پیشنهاد داد که امروز به نام تست تورینگ (Turing Test) شناخته میشود. ایده او ساده اما عمیق بود: اگر یک انسان نتواند تشخیص دهد که در حال گفتگو با یک ماشین است یا یک انسان دیگر، آن ماشین دارای هوش است. این تست هنوز هم یکی از مفاهیم بنیادین در فلسفه هوش مصنوعی محسوب میشود.

جالب است بدانید که نسخه معکوس این تست، امروزه پرکاربردترین ابزار امنیتی اینترنت است. سیستمهای CAPTCHA (کپچا) که روزانه با آنها سر و کار دارید، در واقع یک «تست تورینگ عمومی و کاملاً خودکار» هستند که این بار نه برای تشخیص هوش ماشین، بلکه برای تشخیص انسان از ربات طراحی شدهاند. علاوه بر این، با ظهور مدلهای زبانی قدرتمند، بحث بر سر اعتبار کلاسیک این تست دوباره داغ شده است؛ چرا که هوش مصنوعیهای مدرن در بسیاری از مکالمات توانستهاند انسان را فریب دهند و عملاً این آزمون را پشت سر بگذارند. یعنی نقطه آغاز تاریخچه هوش مصنوعی همچنان برای ما کاربرد دارد.

کنفرانس دارتموث: نامگذاری رسمی (۱۹۵۶)

اگرچه ایدهها وجود داشتند، اما هوش مصنوعی به عنوان یک رشته علمی مستقل، در تابستان سال ۱۹۵۶ متولد شد. در این سال، جان مککارتی (John McCarthy) به همراه ماروین مینسکی (Marvin Minsky) و دیگر پیشگامان، کنفرانسی را در کالج دارتموث برگزار کردند.

در همین رویداد تاریخی بود که جان مککارتی برای اولین بار واژه «Artificial Intelligence» را ابداع کرد. هدف آنها در این کنفرانس، بررسی این فرضیه بود که “هر جنبهای از یادگیری یا هر ویژگی دیگری از هوش، میتواند چنان دقیق توصیف شود که یک ماشین برای شبیهسازی آن ساخته شود.” این کنفرانس را میتوان نقطه شروع رسمی در تاریخچه AI دانست که مسیر تحقیقات دهههای آینده را ترسیم کرد.

سالهای خوشبینی بزرگ در تاریخچه هوش مصنوعی (۱۹۵۶–۱۹۷۴)

پس از کنفرانس دارتموث، دنیای تکنولوژی وارد دوران شکوفایی شد که به «سالهای طلایی» معروف است. در این دو دهه، کامپیوترها کارهایی را انجام دادند که تا پیش از آن غیرممکن به نظر میرسید: حل مسائل جبر، اثبات قضایای هندسه و یادگیری زبان انگلیسی. سازمانهایی مانند دارپا (DARPA) با خوشبینی کامل، بودجههای عظیمی را برای تحقیقات اختصاص دادند، با این تصور که ساخت یک هوش انسانی کامل تنها چند سال زمان میبرد.

الیزا (ELIZA): مادربزرگ چتباتهای امروزی

در اواسط دهه ۶۰ میلادی (۱۹۶۶)، جوزف وایزنبام در MIT برنامهای به نام الیزا (ELIZA) را خلق کرد. الایزا اولین ربات گفتگوگر (Chatbot) تاریخ بود که میتوانست نقش یک رواندرمانگر را بازی کند. اگرچه الیزا واقعاً معنای کلمات را نمیفهمید و صرفاً با تطبیق الگوهای متنی پاسخ میداد، اما توانست بسیاری از کاربران را متقاعد کند که در حال گفتگو با یک انسان دلسوز هستند. الیزا در واقع جد بزرگ چتباتهای پیشرفتهای مثل ChatGPT محسوب میشود.

شیکی (Shakey): اولین ربات الکترونیکی استدلالگر

در اواخر دهه ۶۰، موسسه تحقیقاتی استنفورد (SRI) رباتی به نام «شیکی» را معرفی کرد. برخلاف رباتهای قبلی که صرفاً مجموعهای از دستورات مکانیکی بودند، شیکی میتوانست محیط اطرافش را ببیند، نقشهبرداری کند و برای رسیدن به هدف تصمیم بگیرد (مثلاً جعبهای را جابجا کند تا راهش باز شود). این پروژه، جهش بزرگی در ترکیب بینایی کامپیوتر، پردازش زبان طبیعی و حرکت فیزیکی بود.

در این دوران، ماروین مینسکی با اطمینان پیشبینی کرد که: «ظرف سه تا هشت سال آینده، ماشینی خواهیم داشت که هوشی معادل یک انسان متوسط دارد.» همین وعدههای بزرگ و محققنشده، زمینه را برای سقوط بعدی فراهم کرد.

زمستانهای هوش مصنوعی (AI Winters): دوران رکود و ناامیدی (۱۹۷۴–۱۹۹۳)

پس از هیجانات اولیه، جامعه علمی با واقعیتی تلخ روبرو شد: هوش مصنوعی بسیار پیچیدهتر از آن بود که تصور میشد. وعدههای بزرگی که محقق نشده بودند، باعث دلسردی دولتها و سرمایهگذاران شد. این دوران که با کاهش شدید بودجههای تحقیقاتی و بیتوجهی عمومی همراه بود، به اصطلاح «زمستان هوش مصنوعی» یا AI Winter نامیده میشود.

این دوره در واقع شامل دو موج اصلی رکود بود:

زمستان اول (۱۹۷۴–۱۹۸۰): برخورد با دیوار واقعیت

اولین زمستان زمانی آغاز شد که گزارشهایی انتقادی (مانند گزارش لایتهیل در انگلستان) منتشر شد که نشان میداد هوش مصنوعی در حل مسائل دنیای واقعی ناتوان است.

- مشکل سختافزاری: کامپیوترهای آن زمان قدرت پردازش و حافظه کافی برای نگهداری حجم عظیم دادههای مورد نیاز هوش مصنوعی را نداشتند.

- مشکل ابهام: الگوریتمها در محیطهای آزمایشگاهی (Micro-worlds) خوب کار میکردند، اما به محض مواجهه با ابهامات زبان طبیعی یا پیچیدگیهای دنیای واقعی، شکست میخوردند.

زمستان دوم (۱۹۸۷–۱۹۹۳): سقوط بازار سیستمهای خبره

در دهه ۸۰ میلادی، با ظهور «سیستمهای خبره» (Expert Systems) که از قوانین منطقی برای تصمیمگیری استفاده میکردند، امیدها موقتاً زنده شد. اما این سیستمها بسیار گرانقیمت بودند، به سختی بهروزرسانی میشدند و “یاد نمیگرفتند”؛ بلکه فقط قوانین تزریق شده را اجرا میکردند. با ظهور کامپیوترهای شخصی ارزانتر که میتوانستند همان کارها را انجام دهند، بازار سختافزارهای تخصصی هوش مصنوعی (مثل ماشینهای Lisp) سقوط کرد و زمستان دوم فرا رسید.

تاریخچه هوش مصنوعی در این دوره به ما میآموزد که «چرخه هایپ» (Hype Cycle) چگونه عمل میکند. انتظارات بیش از حد و غیرواقعی، همیشه منجر به سقوطهای دردناک میشود؛ درسی که حتی امروز در مواجهه با فناوریهای جدید باید به خاطر داشت.

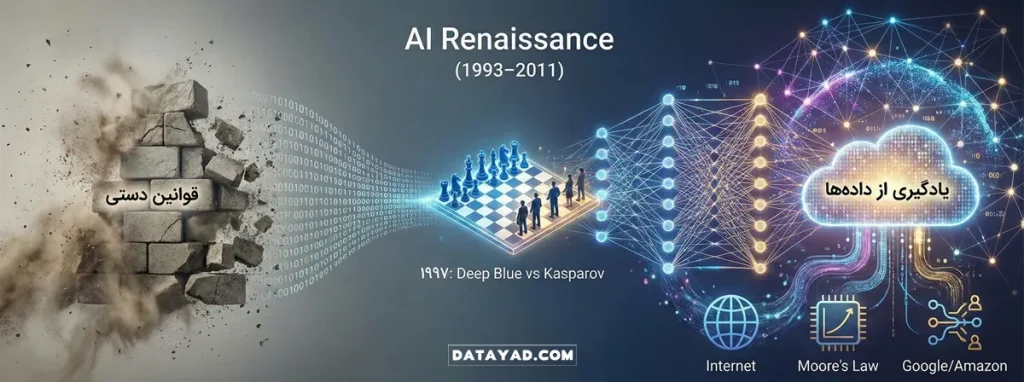

رستاخیز هوش مصنوعی: پیروزی دادهها بر قوانین (۱۹۹۳–۲۰۱۱)

پس از زمستانهای سرد، بهار تاریحچه هوش مصنوعی با تغییری بنیادین در استراتژی آغاز شد. محققان به جای اینکه سعی کنند تمام قوانین دنیا را به صورت دستی برای کامپیوتر کدنویسی کنند (روش سیستمهای خبره)، به سراغ رویکردهای آماری و احتمالات رفتند. حالا سوال این نبود که “چگونه به کامپیوتر بگوییم چه کار کند؟”، بلکه سوال این بود: “چگونه به کامپیوتر اجازه دهیم از دادهها یاد بگیرد؟”. این همان تولد جدی یادگیری ماشین (Machine Learning) در مقیاس کاربردی بود.

نبرد دیپ بلو و کاسپاروف (۱۹۹۷): انسان VS ماشین

یکی از نمادینترین لحظات در تاریخچه هوش مصنوعی، در سال ۱۹۹۷ رقم خورد. ابررایانه شرکت IBM به نام دیپ بلو (Deep Blue) توانست گری کاسپاروف، قهرمان بلامنازع شطرنج جهان را شکست دهد. اگرچه دیپ بلو از هوش مصنوعی به معنای مدرن (یادگیری عمیق) استفاده نمیکرد و بیشتر متکی بر قدرت محاسباتی وحشتناک برای بررسی میلیونها حرکت در ثانیه بود، اما این پیروزی یک پیام واضح داشت: ماشینها در حوزههای فکری پیچیده، در حال پیشی گرفتن از انسان هستند.

نفوذ آرام به زندگی روزمره

برخلاف دورههای قبل که هوش مصنوعی پر سر و صدا اما ناکارآمد بود، در این دوره AI به صورت «نامرئی» وارد زندگی شد. الگوریتمهای گوگل شروع به رتبهبندی صفحات وب کردند، سیستمهای تشخیص گفتار (Speech Recognition) بهبود یافتند و سایتهایی مثل آمازون شروع به استفاده از سیستمهای توصیه گر کردند.

عوامل موفقیت در این دوره سه چیز بود:

- قانون مور: افزایش تصاعدی قدرت پردازش کامپیوترها.

- اینترنت: دسترسی به حجم عظیمی از دادهها برای آموزش الگوریتمها.

- ریاضیات جدید: پذیرش مدلهای احتمالی (مانند شبکههای بیزی) به جای منطق قطعی.

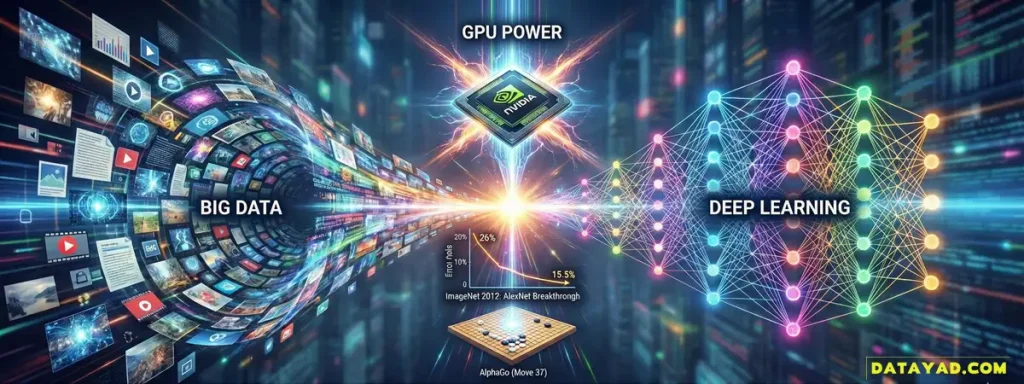

عصر دادههای بزرگ و یادگیری عمیق (۲۰۱۱–۲۰۲۲): انفجار هوشمند

اگر سالهای قبل دوران “تلاش برای ساخت هوش” بود، این دهه دوران “شکوفایی هوش مصنوعی” است. در حدود سال ۲۰۱۱، سه عامل کلیدی دست به دست هم دادند تا قفلهای قدیمی باز شوند:

- دادههای بزرگ (Big Data): میلیاردها تصویر، متن و ویدیو در اینترنت موجود شد.

- پردازندههای گرافیکی (GPU): سختافزارهایی که میتوانستند محاسبات ماتریسی پیچیده را با سرعتی باورنکردنی انجام دهند.

- الگوریتمهای یادگیری عمیق: احیای شبکههای عصبی چندلایه که پیش از این نادیده گرفته میشدند.

رقابت ایمیجنت (ImageNet): جام جهانی بینایی ماشین

برای درک بزرگی این اتفاق، باید به سال ۲۰۱۰ برگردیم. در آن زمان، رقابتی سالانه به نام ImageNet (ILSVRC) برگزار میشد که حکم جام جهانی را برای محققان هوش مصنوعی داشت. چالش ساده اما دشوار بود: نرمافزارها باید هزاران تصویر را میدیدند و تشخیص میدادند که تصویر مربوط به چیست (گربه، کشتی، قارچ و…). تا سال ۲۰۱۱، بهترین الگوریتمهای جهان خطایی حدود ۲۶ درصد داشتند و پیشرفتها بسیار کند و ناچیز بود. جامعه علمی تقریباً پذیرفته بود که تشخیص دقیق اشیاء توسط کامپیوتر، شاید دههها زمان ببرد.

لحظه تاریخی الکسنت (۲۰۱۲) و انقلاب GPU

در سال ۲۰۱۲، همه چیز در رقابت ImageNet تغییر کرد. تیمی از دانشگاه تورنتو (شامل جفری هینتون، ایلیا سوتسکوِر و الکس کریزفسکی) مدلی به نام AlexNet را معرفی کردند. نتیجه شوکهکننده بود: الکسنت نرخ خطا را به ناگهان از ۲۶٪ به ۱۵.۳٪ کاهش داد! این اختلاف فاحش، دیگر یک بهبود ساده نبود، بلکه یک انقلاب بود.

راز موفقیت الکسنت چه بود؟ آنها دو کار متفاوت انجام دادند که به استاندارد امروز تبدیل شد:

- استفاده از شبکههای عصبی عمیق (CNN): مدلهایی که ساختاری شبیه به مغز انسان داشتند، اما سالها به دلیل پیچیدگی محاسباتی کنار گذاشته شده بودند.

- استفاده از پردازندههای گرافیکی (GPU): این تیم برای اولین بار متوجه شد که کارتهای گرافیک NVIDIA (که مخصوص بازیهای کامپیوتری بودند)، در انجام محاسبات موازی ریاضی بسیار سریعتر از CPU های معمولی عمل میکنند. آنها با استفاده از دو کارت گرافیک GTX 580، کاری کردند که آموزش شبکه عصبی به جای ماهها، در چند روز انجام شود.

این موفقیت ثابت کرد که ترکیب «دادههای انبوه + الگوریتمهای عمیق + قدرت پردازش GPU» کلید حل مسائل پیچیده است.

آلفاگو (AlphaGo) و حرکت ۳۷ (۲۰۱۶)

اگر شکست کاسپاروف در شطرنج (۱۹۹۷) نشاندهنده قدرت محاسباتی بود، شکست لی سدول (قهرمان افسانهای بازی Go) در سال ۲۰۱۶ نشاندهنده «شهود مصنوعی» بود. بازی Go به دلیل پیچیدگی وحشتناکاش، با روشهای محاسباتی معمولی قابل حل نبود. سیستم AlphaGo (محصول شرکت DeepMind گوگل) نه تنها بازی را برد، بلکه حرکتی انجام داد (حرکت ۳۷) که هیچ انسانی آن را انجام نمیداد. این حرکت نشان داد که هوش مصنوعی دیگر فقط تقلید نمیکند، بلکه میتواند خلاقیت استراتژیک داشته باشد.

چرا این دوره مهم است؟ در این بازه زمانی، دستیارهای صوتی (Siri و Alexa)، خودروهای خودران و سیستمهای تشخیص چهره از فیلمهای علمی-تخیلی به واقعیت روزمره تبدیل شدند.

انقلاب هوش مصنوعی مولد (۲۰۲۳ تا امروز)

اگر سال ۲۰۱۲ سال “انقلاب بینایی” بود، سال ۲۰۲۳ را باید سال “انقلاب زبان و خلاقیت” نامید. تا پیش از این، هوش مصنوعی بیشتر ابزاری برای “تحلیل و طبقهبندی” بود (مثلاً تشخیص اسپم ایمیل یا پیشنهاد فیلم). اما با ظهور هوش مصنوعی مولد (Generative AI)، ماشینها برای اولین بار توانایی “خلق کردن” پیدا کردند.

ظهور ChatGPT

در نوامبر ۲۰۲۲، شرکت OpenAI چتبات ChatGPT را منتشر کرد. این ابزار که بر پایه معماری مدلهای زبانی بزرگ (LLMs) ساخته شده بود، توانست تنها در دو ماه به ۱۰۰ میلیون کاربر فعال برسد؛ رکوردی که اینستاگرام برای رسیدن به آن ۲ سال زمان صرف کرد. ناگهان مردم عادی دیدند که میتوانند با یک ماشین صحبت کنند، از او بخواهند شعر بگوید، کد برنامهنویسی بنویسد یا حتی برایشان استراتژی بازاریابی بچیند. این لحظه، به تعبیر بسیاری از کارشناسان، «لحظه آیفون» برای تاریخچه هوش مصنوعی بود؛ لحظهای که تکنولوژی همگانی شد.

زیرساخت فنی: همه چیز زیر سر «ترنسفورمرها» است

شاید بپرسید این جهش ناگهانی چگونه رخ داد؟ ریشه این تحول به مقالهای در سال ۲۰۱۷ توسط گوگل با عنوان “Attention Is All You Need” بازمیگردد. آنها معماری جدیدی به نام ترنسفورمر (Transformer) را معرفی کردند که به مدلها اجازه میداد به جای خواندن کلمه به کلمه متن، کل ساختار و ارتباطات معنایی جملات را همزمان درک کنند. همین معماری، موتور محرک ابزارهایی مثل GPT-4، Claude و مدلهای تصویرساز مثل Midjourney شد.

نتیجهگیری: آینده هوش مصنوعی و جایگاه ما

با مرور تاریخچه هوش مصنوعی، از رویاهای آلن تورینگ تا قدرت حیرتانگیز مدلهای امروزی، یک الگوی تکرارشونده را میبینیم: «غیرممکنهای دیروز، روزمرگیهای امروزند.»

ما اکنون در آستانه ورود به عصر AGI (هوش عمومی مصنوعی) هستیم؛ جایی که ماشینها نه فقط در یک کار خاص، بلکه در تمام فعالیتهای شناختی همسطح یا برتر از انسان عمل خواهند کرد. اما جای نگرانی نیست؛ تاریخ نشان داده است که تکنولوژی جایگزین انسان نمیشود، بلکه جایگزین انسانهایی میشود که از تکنولوژی استفاده نمیکنند.

اکنون که با گذشته و حال این فناوری آشنا شدید، بهترین زمان است که نقش خود را در آینده آن تعریف کنید. اگر میخواهید صرفاً تماشاگر نباشید و به یک متخصص در این دنیای جدید تبدیل شوید، پیشنهاد میکنیم نگاهی به دورههای آموزش هوش مصنوعی و علم داده در دیتایاد بیندازید. ما در دیتایاد مسیر یادگیری شما را از مفاهیم پایه تا پیشرفتهترین تکنیکهای روز، هموار کردهایم.