اگر بخواهیم صادقانه نگاه کنیم، زندگی ما انسانها از سادهترین کارهای روزمره تا پیچیدهترین تصمیمات مهندسی، یک فرآیند بهینهسازی مداوم است. ما همیشه به دنبال کوتاهترین مسیر برای رسیدن به مقصد یا کمهزینهترین راه برای خرید هستیم. در دنیای کدها و دادهها هم داستان دقیقاً همین است. بسیاری از شاخههای جذاب در الگوریتم های هوش مصنوعی بدون حضور یک ناظر هوشمند که بهترین مسیر را نشان دهد، عملاً کارایی خود را از دست میدهند. الگوریتم های بهینه سازی دقیقاً همان ناظرانی هستند که به ما کمک میکنند از میان میلیونها انتخاب اشتباه یا معمولی، «بهترین» پاسخ ممکن را شکار کنیم. در این مقاله از دیتایاد، قرار است با هم به قلب این الگوریتمها سفر کنیم و ببینیم چطور ریاضیات و هوش مصنوعی دست به دست هم میدهند تا سختترین مسائل جهان را حل کنند.

مفاهیم پایه الگوریتم های بهینه سازی

شاید بپرسید وقتی از بهینهسازی حرف میزنیم، دقیقاً از چه چیزی صحبت میکنیم؟ تصور کنید در یک مه غلیظ در پای کوه ایستادهاید و میخواهید به قله (بلندترین نقطه) برسید، اما فقط یک متر جلوی پای خود را میبینید. شما باید با هر قدم، بسنجید که آیا به سمت بالا میروید یا پایین.

در دنیای تکنولوژی، هر مسئله بهینهسازی شامل سه قطعه پازل اصلی است که اگر هر کدام نباشد، تصویر ما ناقص میماند:

- هدف ما چیست؟ (تابع هدف): همان متری که با آن موفقیت را اندازه میگیریم. مثلاً در آموزش یک مدل یادگیری ماشین، هدف ما این است که «خطا» را به حداقل برسانیم.

- چه ابزارهایی در دست داریم؟ (متغیرهای تصمیم): اینها همان پیچ و مهرههایی هستند که میتوانیم آنها را بچرخانیم تا نتیجه عوض شود.

- خط قرمزها کدامند؟ (محدودیتها): همیشه محدودیتهایی وجود دارد؛ مثلاً حافظه محدود سرور یا بودجهای که نباید از یک مبلغ خاص بیشتر شود.

چالش اصلی اینجاست که همیشه قلهای که روی آن ایستادهاید، بلندترین قله جهان نیست! گاهی الگوریتمها در یک «تله محلی» گیر میافتند و فکر میکنند به بهترین نتیجه رسیدهاند. هنر اصلی در طراحی الگوریتم های بهینه سازی این است که روشی ابداع کنیم که نه تنها در تلهها نیفتد، بلکه با کمترین تلاش، ما را به قله اصلی یا همان «بهینه مطلق» برساند.

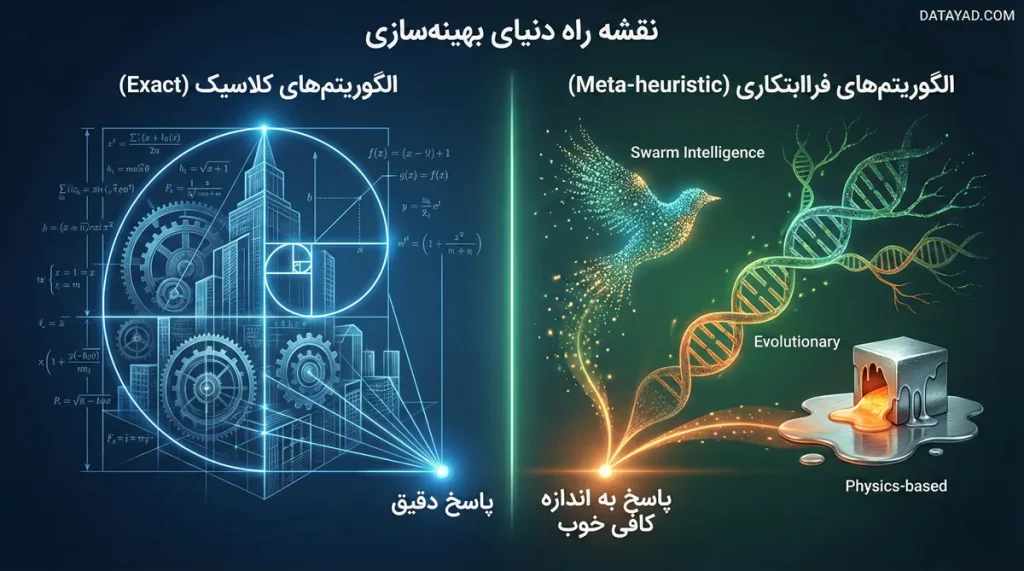

نقشه راه دنیای بهینهسازی؛ از روشهای کلاسیک تا هوش جمعی

دنیای الگوریتم های بهینه سازی آنقدر وسیع است که اگر بدون نقشه وارد آن شوید، احتمالاً در میان فرمولها و اسامی عجیبوغریب گم خواهید شد. برای اینکه درک بهتری از این فضا داشته باشیم، متخصصان معمولاً این الگوریتمها را به دو خانواده بزرگ تقسیم میکنند. هر کدام از این خانوادهها، استراتژی خاص خود را برای پیدا کردن «بهترین پاسخ» دارند.

۱. الگوریتمهای کلاسیک یا ریاضی (Exact Algorithms)

اینها پدربزرگهای دنیای بهینهسازی هستند! روشهایی که بر پایه محاسبات دقیق ریاضی و مشتقگیری بنا شدهاند. اگر مسئله شما خیلی پیچیده نباشد و فضای جستجوی کوچکی داشته باشید، این الگوریتمها با دقت ۱۰۰ درصد، بهترین پاسخ ممکن را پیدا میکنند. روشهایی مثل «برنامهنویسی خطی» (Linear Programming) در این دسته قرار میگیرند. اما یک مشکل بزرگ وجود دارد: وقتی مسئله خیلی بزرگ و چندبعدی میشود، این روشها کم میآورند و زمان اجرای آنها آنقدر طولانی میشود که عملاً غیرقابل استفاده میشوند.

۲. الگوریتمهای فراابتکاری یا تکاملی (Meta-heuristic)

اینجاست که دانشجوهای هوش مصنوعی هیجانزده میشوند! وقتی روشهای ریاضی از حل مسائل غولآسا باز میمانند، ما به سراغ طبیعت میرویم. الگوریتمهای فراابتکاری به جای حل دقیق معادلات، از «حدس هوشمندانه» و «تکرار» استفاده میکنند. آنها شاید همیشه دقیقترین پاسخِ ریاضی را پیدا نکنند، اما در زمانی بسیار کوتاه، پاسخی را به شما میدهند که «به اندازه کافی خوب» است.

این الگوریتمها خودشان به دستههای کوچکتری تقسیم میشوند که هر کدام میتوانند موضوع یک مقاله مفصل باشند:

- الگوریتمهای مبتنی بر تکامل: مانند الگوریتم ژنتیک (GA) که از بقای برترینها در طبیعت الهام گرفته است.

- الگوریتمهای مبتنی بر هوش جمعی (Swarm Intelligence): مانند الگوریتم بهینهسازی توده ذرات (PSO) یا کلونی مورچگان که رفتار گروهی حیوانات را شبیهسازی میکنند.

- الگوریتمهای مبتنی بر فیزیک: مانند الگوریتم تبرید شبیهسازی شده (Simulated Annealing) که از فرآیند ذوب و انجماد فلزات الگوبرداری شده است.

الگوریتمهای فراابتکاری؛ الهام از هوش نهفته در طبیعت

وقتی معادلات ریاضی برای حل مسائل پیچیده به بنبست میرسند، طبیعت با میلیونها سال تجربه وارد میدان میشود. الگوریتمهای فراابتکاری (Metaheuristic) با الهام از رفتار پرندگان، مورچهها و حتی قوانین فیزیک، راههای میانبری را برای حل مسائل غیرممکن ابداع کردهاند. بیایید با چند مورد از پرچمداران این حوزه آشنا شویم:

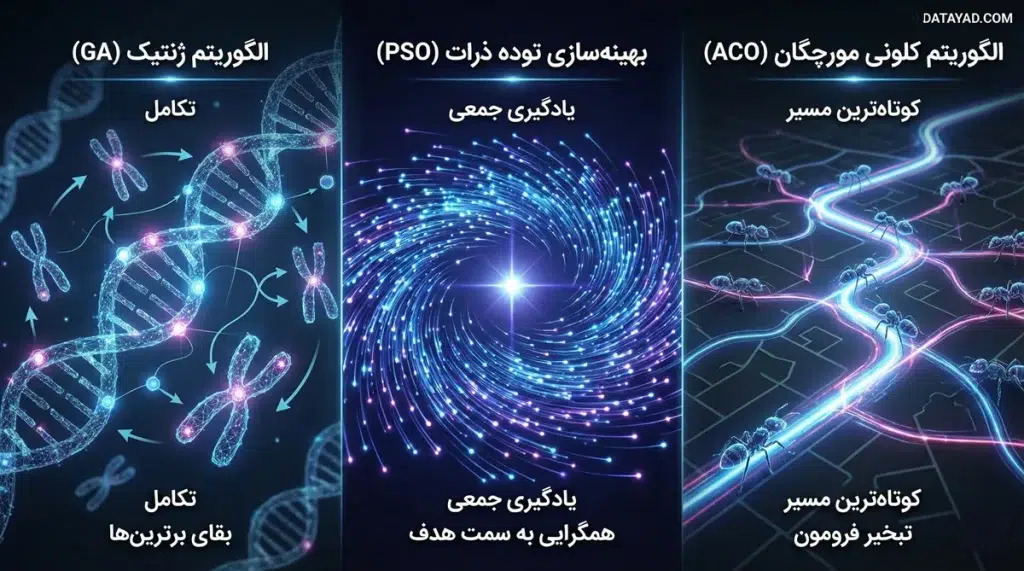

الگوریتم ژنتیک (Genetic Algorithm – GA)؛ بقای برترینها

الگوریتم ژنتیک محبوبترین فرزند خانواده الگوریتمهای تکاملی است که مستقیماً از نظریه داروین الهام گرفته شده. در این روش، هر پاسخ احتمالی برای مسئله، مانند یک «کروموزوم» در نظر گرفته میشود. ما با یک جمعیت اولیه (تعدادی پاسخ تصادفی) شروع میکنیم و در هر مرحله، مراحل زیر را تکرار میکنیم:

- انتخاب (Selection): پاسخهایی که به هدف نزدیکترند (برازش بالاتری دارند)، شانس بیشتری برای والدین شدن پیدا میکنند.

- ترکیب (Crossover): والدین منتخب، بخشهایی از ویژگیهای خود را با هم ترکیب میکنند تا فرزندانی (پاسخهای جدیدی) ایجاد کنند که احتمالاً از خودشان بهتر هستند.

- جهش (Mutation): برای اینکه الگوریتم در یک تله محلی گیر نکند، گاهی به صورت تصادفی تغییرات کوچکی در فرزندان ایجاد میکنیم تا فضاهای ناشناخته را هم جستجو کنیم. کاربرد: این الگوریتم در مسائل زمانبندی (Scheduling) و بهینهسازی توپولوژی سازهها فوقالعاده عمل میکند.

بهینهسازی توده ذرات (PSO)؛ رقص گروهی برای رسیدن به هدف

الگوریتم PSO که در سال ۱۹۹۵ معرفی شد، بر خلاف ژنتیک، بر پایه «یادگیری» و «تعامل اجتماعی» است. در اینجا هر پاسخ یک «ذره» (Particle) نامیده میشود که در فضای مسئله پرواز میکند. هر ذره دو اطلاعات مهم را در حافظهاش نگه میدارد:

- بهترین موقعیتی که خودش تا به حال تجربه کرده (Pbest).

- بهترین موقعیتی که کل گروه تا به حال به آن رسیده است (Gbest).

هر ذره سرعت و جهت حرکت خود را با ترکیب این دو اطلاعات تنظیم میکند. به زبان ساده، هر ذره هم به تجربه خودش اعتماد میکند و هم به خرد جمعی گروه. این تعامل باعث میشود که کل توده به سرعت به سمت نقطه بهینه همگرا شوند. PSO به دلیل سرعت بالا، در تنظیم وزنهای شبکههای عصبی و مسائل کنترل سیستم بسیار پرطرفدار است.

الگوریتم کلونی مورچگان (ACO)؛ کوتاهترین مسیر به سمت غذا

این الگوریتم یکی از باهوشترین روشها برای حل مسائل ترکیبیاتی است. مورچهها در طبیعت هنگام راه رفتن، مادهای شیمیایی به نام «فرومون» از خود به جا میگذارند.

- وقتی چندین مسیر برای رسیدن به غذا وجود داشته باشد، مورچههایی که از مسیر کوتاهتر میروند، زودتر برمیگردند؛ پس در واحد زمان، فرومون بیشتری روی مسیر کوتاه تجمع پیدا میکند.

- مورچههای بعدی ترجیح میدهند از مسیری بروند که بوی فرومون بیشتری دارد. در پیادهسازی کامپیوتری، ما از این ویژگی برای یافتن کوتاهترین مسیر در گرافها استفاده میکنیم. نکته هوشمندانه اینجاست که فرومونها به مرور زمان «تبخیر» میشوند؛ این یعنی اگر مسیری دیگر بهینه نباشد، به تدریج از حافظه الگوریتم پاک میشود. کاربرد: بهینهسازی مسیر یابی در شبکههای کامپیوتری و لجستیک حملونقل از اصلیترین میزبانان این الگوریتم هستند.

یک مثال واقعی: تصور کنید یک سیستم توزیع کالا میخواهد ۲۰ بسته را با کمترین مصرف سوخت و در کوتاهترین زمان به مقصد برساند. این یک مسئله «فروشنده دورهگرد» است که حل آن با روشهای عادی قرنها طول میکشد! اما الگوریتم های بهینه سازی مثل کلونی مورچگان، با شبیهسازی مسیرهای مختلف، در عرض چند ثانیه بهترین ترتیبِ توقف را برای راننده پیدا میکنند.

چالشهای اساسی در الگوریتم های بهینه سازی؛ تلهها و راهکارها

طراحی و اجرای الگوریتم های بهینه سازی همیشه به سادگیِ یافتن یک نقطه روی نمودار نیست. در دنیای واقعی، به ویژه در پروژههای یادگیری عمیق که با میلیونها پارامتر سر و کار داریم، مسیر رسیدن به پاسخ با موانع جدی روبروست. شناخت این چالشها تفاوت میان یک معمار خبره هوش مصنوعی و یک اپراتور ساده را مشخص میکند.

۱. بهینه محلی در مقابل بهینه مطلق (Local vs. Global Optima)

بزرگترین کابوس در دنیای بهینهسازی، گیر افتادن در تلهی «بهینه محلی» است. تصور کنید در حال کوهنوردی هستید و به نوک یک تپه میرسید؛ از آنجا به هر طرف نگاه میکنید، مسیر رو به پایین است. ممکن است فکر کنید به قله رسیدهاید، در حالی که قله اصلی (بهینه مطلق) فرسنگها دورتر و بسیار مرتفعتر است. بسیاری از الگوریتم های بهینه سازی کلاسیک در این تله میافتند. اما روشهای پیشرفتهتر در علم داده، با استفاده از مکانیزمهایی مثل «جهش» یا «جستجوی تصادفی»، تلاش میکنند از این تلهها بیرون بپرند تا به بهترین پاسخ جهانی دست یابند.

۲. تعادل میان اکتشاف و استخراج (Exploration vs. Exploitation)

یک الگوریتم هوشمند باید بتواند بین دو استراتژی توازن برقرار کند:

- اکتشاف (Exploration): یعنی جستجو در مناطق کاملاً جدید و ناشناخته از فضای مسئله برای پیدا کردن شانسهای بهتر.

- استخراج (Exploitation): یعنی تمرکز بر روی یک منطقه امیدبخش و جستجوی دقیق در اطراف آن برای رسیدن به عدد نهایی. اگر یک الگوریتم بهینهسازی بیش از حد به اکتشاف بپردازد، هرگز روی یک پاسخ خوب متمرکز نمیشود و اگر فقط به استخراج تکیه کند، قطعاً در اولین چاله (بهینه محلی) گیر میافتد. تنظیم این تعادل، هنر اصلی متخصصان در پیادهسازی مدلهای یادگیری ماشین است.

۳. نفرین ابعاد (Curse of Dimensionality)

در مسائل ساده، ما با دو یا سه متغیر روبرو هستیم، اما در یادگیری عمیق و مدلهای بزرگ زبانی، فضای جستجو ممکن است هزاران بُعد داشته باشد. با افزایش ابعاد، حجم فضای جستجو به صورت نمایی رشد میکند و یافتن پاسخ بهینه مانند پیدا کردن سوزن در انبار کاهی به وسعت یک کهکشان میشود. در اینجا اهمیت انتخاب الگوریتم های بهینه سازی کارآمد که با محاسبات موازی و توزیعشده سازگار باشند، دوچندان میشود.

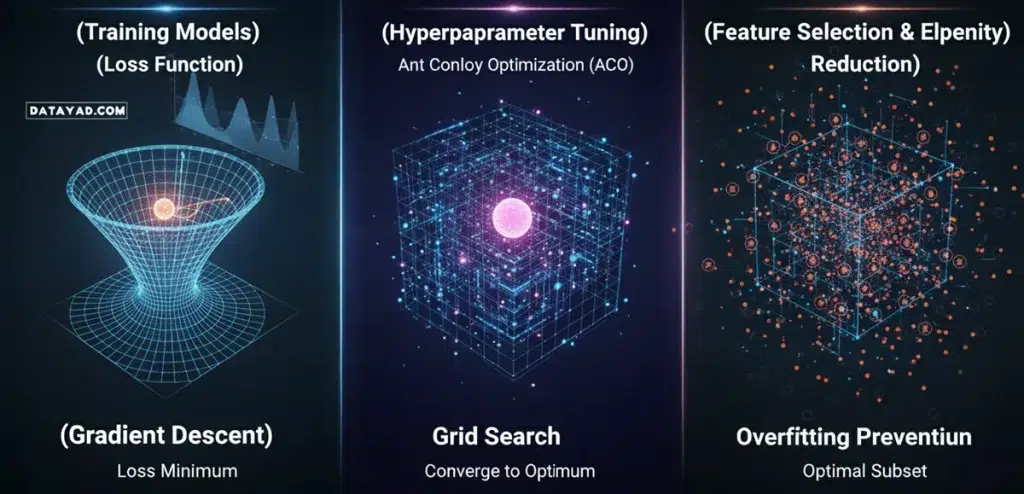

پیوند ناگسستنی بهینهسازی و مدلهای هوشمند

بسیاری از افراد تصور میکنند که هوش مصنوعی یک جعبه سیاه جادویی است که به خودی خود یاد میگیرد، اما اگر پردهها را کنار بزنیم، خواهیم دید که در قلب هر سیستم هوشمندی، یک موتور جستجوی دقیق از الگوریتم های بهینه سازی در حال کار است. در واقع، فرآیند «یادگیری» در مدلهای کامپیوتری، چیزی جز تلاش برای بهینهسازی پارامترها نیست. بیایید این پیوند را در سه سطح کلیدی بررسی کنیم:

۱. آموزش مدلها؛ نبرد با تابع هزینه

وقتی یک مدل یادگیری ماشین را با دادههای مختلف تغذیه میکنید، مدل شروع به پیشبینی میکند. تفاوت میان پیشبینی مدل و واقعیت، در مفهومی به نام «تابع هزینه» (Loss Function) تعریف میشود. وظیفه اصلی الگوریتم های بهینه سازی در اینجا این است که راهی پیدا کنند تا این خطا یا هزینه را به حداقل برسانند. معروفترین ابزار در این حوزه، الگوریتم گرادیان کاهشی (Gradient Descent) است. این الگوریتم با محاسبه جهت تغییرات، گامبهگام پارامترهای مدل را طوری تغییر میدهد که به کمترین میزان خطا برسیم. بدون این بهینهسازی، مدلهای یادگیری عمیق مانند ابزارهای تشخیص چهره یا ترجمه ماشینی، هرگز نمیتوانستند با دقت بالا عمل کنند.

۲. تنظیم ابرپارامترها (Hyperparameter Tuning)

در هر پروژه علم داده، متخصصان با متغیرهایی روبرو هستند که خودِ مدل نمیتواند آنها را یاد بگیرد؛ مثل نرخ یادگیری (Learning Rate) یا تعداد لایهها در یک شبکه عصبی. انتخاب بهترین ترکیب برای این متغیرها، خودش یک مسئله بهینهسازی بزرگ است. در اینجا متخصصان از الگوریتم های بهینه سازی هوشمندتری مثل جستجوی شبکهای (Grid Search) یا حتی روشهای پیشرفتهتر مانند بهینهسازی بیزی و الگوریتم ژنتیک استفاده میکنند تا بهترین پیکربندی را برای مدل پیدا کنند. اینجاست که تفاوت میان یک مدل معمولی و یک مدل فوقهوشمند مشخص میشود.

۳. انتخاب ویژگی و کاهش ابعاد در علم داده

در مسائل بزرگ علم داده، ما گاهی با صدها ویژگی (Feature) روبرو هستیم که همه آنها مفید نیستند. استفاده از الگوریتم های بهینه سازی به ما کمک میکند تا موثرترین ویژگیها را انتخاب کرده و نویز را حذف کنیم. این کار نه تنها سرعت آموزش مدل را افزایش میدهد، بلکه از پدیده «بیشبرازش» (Overfitting) نیز جلوگیری میکند.

در حقیقت، اگر بخواهیم در یک جمله خلاصه کنیم: الگوریتم های بهینه سازی همان زبان مشترکی هستند که ریاضیات را به هوش، و داده را به دانش تبدیل میکنند. در بخش آموزش هوش مصنوعی دیتایاد، ما دقیقاً روی همین نقطه تمرکز میکنیم؛ یعنی یادگیری عمیقِ مفاهیم بهینهسازی برای ساخت مدلهایی که در دنیای واقعی حرفی برای گفتن داشته باشند.

مقایسه هوشمندانه؛ کدام الگوریتم برای مسئله شما ساخته شده است؟

| نام الگوریتم | استراتژی جستجو | پیچیدگی محاسباتی | نقطه قوت اصلی | کاربرد در یادگیری ماشین |

| گرادیان کاهشی (GD) | کلاسیک / ریاضی | کم تا متوسط | همگرایی سریع در توابع محدب | آموزش شبکههای عصبی و رگرسیون |

| ژنتیک (GA) | تکاملی / احتمالی | بالا | خروج از تلههای بهینه محلی | انتخاب ویژگی و طراحی معماری شبکه |

| توده ذرات (PSO) | هوش جمعی / ذرات | متوسط | توازن عالی بین سرعت و دقت | تنظیم ابرپارامترها (Hyperparameters) |

| تبرید شبیهسازی شده | فیزیکی / احتمالی | متوسط | جستجوی وسیع در فضاهای ناهموار | حل مسائل پیچیده تخصیص منابع |

| کلونی مورچگان (ACO) | هوش جمعی / مسیر | بالا | یافتن مسیرهای کوتاه در گرافها | بهینهسازی شبکههای توزیع و لجستیک |

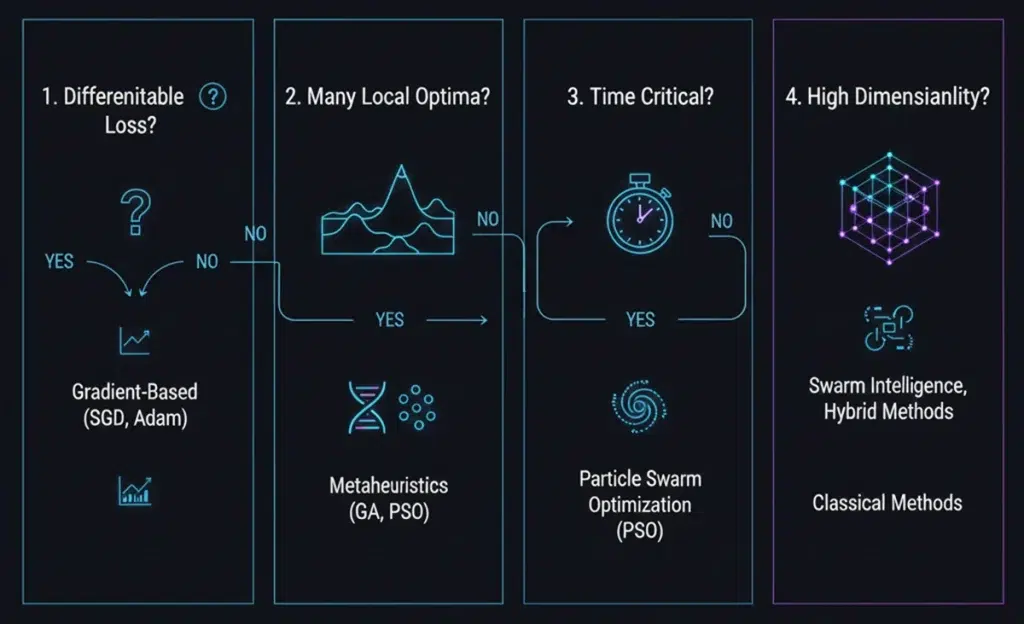

راهنمای گامبهگام برای انتخاب الگوریتم بهینهسازی مناسب

اگر در حال کار روی یک پروژه یادگیری ماشین هستید و نمیدانید کدام یک از الگوریتم های بهینه سازی را انتخاب کنید، این نقشه راه را دنبال کنید:

- آیا تابع هدف شما مشتقپذیر است؟ اگر پاسخ مثبت است و با مسائل سادهتری در علم داده روبرو هستید، روشهای مبتنی بر گرادیان (مثل SGD یا Adam) معمولاً سریعترین و بهترین نتیجه را میدهند.

- آیا فضای جستجو قلهها و درههای زیادی دارد؟ اگر با یک مسئله Non-convex روبرو هستید که احتمال گیر افتادن در «بهینه محلی» زیاد است، حتماً از الگوریتمهای فراابتکاری مانند الگوریتم ژنتیک یا توده ذرات (PSO) استفاده کنید.

- زمان برای شما چقدر حیاتی است؟ در پروژههایی که نیاز به پاسخهای Real-time دارند، الگوریتم PSO به دلیل سادگی محاسباتی و سرعت همگرایی بالا، بر الگوریتمهای سنگینی مثل ژنتیک برتری دارد.

- ابعاد مسئله چقدر بزرگ است؟ در مسائل با ابعاد بسیار بالا (مانند یادگیری عمیق)، الگوریتمهای هوش جمعی تمایل بیشتری به یافتن پاسخهای قابل قبول در زمان معقول دارند.

فراموش نکنید که در بسیاری از رقابتهای سطح بالای هوش مصنوعی، متخصصان از الگوریتم های بهینه سازی ترکیبی (Hybrid) استفاده میکنند؛ یعنی ترکیب قدرت جستجوی وسیعِ یک الگوریتم تکاملی با دقتِ نقطهزنیِ یک روش کلاسیک.

ابزارهای پیادهسازی الگوریتم های بهینه سازی در پایتون

اگر میخواهید از تئوری به سمت عمل حرکت کنید، زبان برنامهنویسی پایتون کتابخانههای فوقالعادهای برای اجرای این الگوریتمها دارد:

- SciPy (Optimize): بهترین گزینه برای روشهای کلاسیک و ریاضی.

- PyGMO / DEAP: کتابخانههای تخصصی برای اجرای الگوریتم های بهینه سازی تکاملی مثل ژنتیک.

- Optuna: یک ابزار مدرن و قدرتمند که امروزه در هوش مصنوعی برای تنظیم خودکار ابرپارامترها استفاده میشود.

- PySwarm: به صورت اختصاصی برای پیادهسازی الگوریتم PSO طراحی شده است.

جمعبندی و نتیجهگیری

شناخت و تسلط بر الگوریتم های بهینه سازی، مرز میان یک کدنویس ساده و یک متخصص خبره در حوزههای هوش مصنوعی، یادگیری ماشین و علم داده است. ما در این مقاله آموختیم که چگونه از دل طبیعت و ریاضیات، ابزارهایی برای حل سختترین مسائل مهندسی استخراج کنیم. به یاد داشته باشید که کلید موفقیت در این حوزه، نه فقط حفظ کردن فرمولها، بلکه درک عمیق منطقِ پشت هر الگوریتم و تمرین مداوم است.

اگر آمادهاید تا این تئوریها را به مهارتهای کلیدی در بازار کار تبدیل کنید، راهنمای شروع یادگیری هوش مصنوعی رو از دست ندید! ما در کنار شما هستیم تا مسیر یادگیری را برایتان «بهینه» کنیم.