در عصر دادهمحور امروز، دسترسی سریع و هوشمندانه به اطلاعات موجود در وبسایتها میتواند برگ برندهای برای تحلیلگران، کسبوکارها و پژوهشگران باشد. اما بیشتر این دادهها بهصورت ساختارنیافته در صفحات HTML ذخیره شدهاند و بهسادگی قابل دانلود یا استفاده مستقیم نیستند. اینجاست که وب اسکرپینگ با پایتون (Web Scraping) وارد عمل میشود.

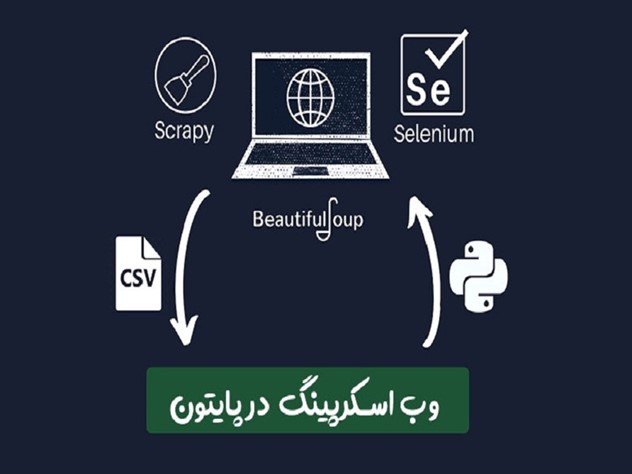

پایتون، بهعنوان یکی از محبوبترین زبانهای برنامهنویسی در حوزه داده، با داشتن کتابخانههایی مثل BeautifulSoup، Requests، Selenium و Scrapy، فرایند وب اسکرپینگ را بهشکل ساده، منعطف و قدرتمند فراهم میکند. با کمک این ابزارها میتوان اطلاعاتی مثل قیمت محصولات، مقالات خبری، دادههای آماری یا هر محتوای متنی دیگری را از وبسایتها استخراج و در قالبی قابل استفاده ذخیرهسازی کرد.در ادامه این مقاله، با مفاهیم پایه، کاربردها، ابزارها و چالشهای قانونی و فنی وب اسکرپینگ با پایتون آشنا خواهیم شد.

اگر وقت کافی برای مطالعه نداریدبرای راحتی و درک بهتر، میتوانید خلاصه این مطلب را به صورت پادکست گوش کنید.

وب اسکرپینگ چیست؟

آموزش وب اسکرپینگ توسط بسیاری از مراکز فنی و تخصصی در زمینه تکنولوژی ارائه میشود که شاید برای برخی از افراد، نامفهوم باشد. در این روش از رباتهای مختلف برای جمع آوری اطلاعات از سایتهای متنوع استفاده میشود. این برنامه به جمع آوری کدهای اصلی و اطلاعات سایتها میپردازد تا در ادامه از این اطلاعات برای نیاز و شرایط خود استفاده کنند.

تعریف ساده وب اسکرپینگ

همانطور که به آن اشاره کردیم، وب اسکریپینگ دیجیکالا به معنای استخراج داده و اطلاعات از یک سایت میباشد. انجام وب اسکرپینگ با پایتون نیز یکی از روشهای ساده استخراج اطلاعات میباشد که مخاطبان بسیار زیادی دارد. در روش وب اسکرپینگ، میتوان به گونهای برنامهریزی کرد که کل اطلاعات یک سایت یا فقط بخشی که مخاطب به آن نیاز دارد، استخراج شود. آخرین مرحله در فرایند Web Scraping، خروجی اطلاعات در یک قالب کاربردی برای مخاطب است. برای فایل خروجی از فرمتهایی مثل اکسل، CSV و JSON استفاده میشود.

به نقل از سایت scrapingbee:

«وب اسکرپینگ با پایتون، در ابتدا شاید دلهره آور به نظر برسد، اما با پیروی از قوانین و رویکردهای ساختار یافته، میتوان روند را به طور قابل توجهی ساده کرد. تمام افراد مبتدی و باتجربه هنگام استخراج اطلاعات با این روش، باید قوانین و استانداردهای لازم را رعایت کنند.»

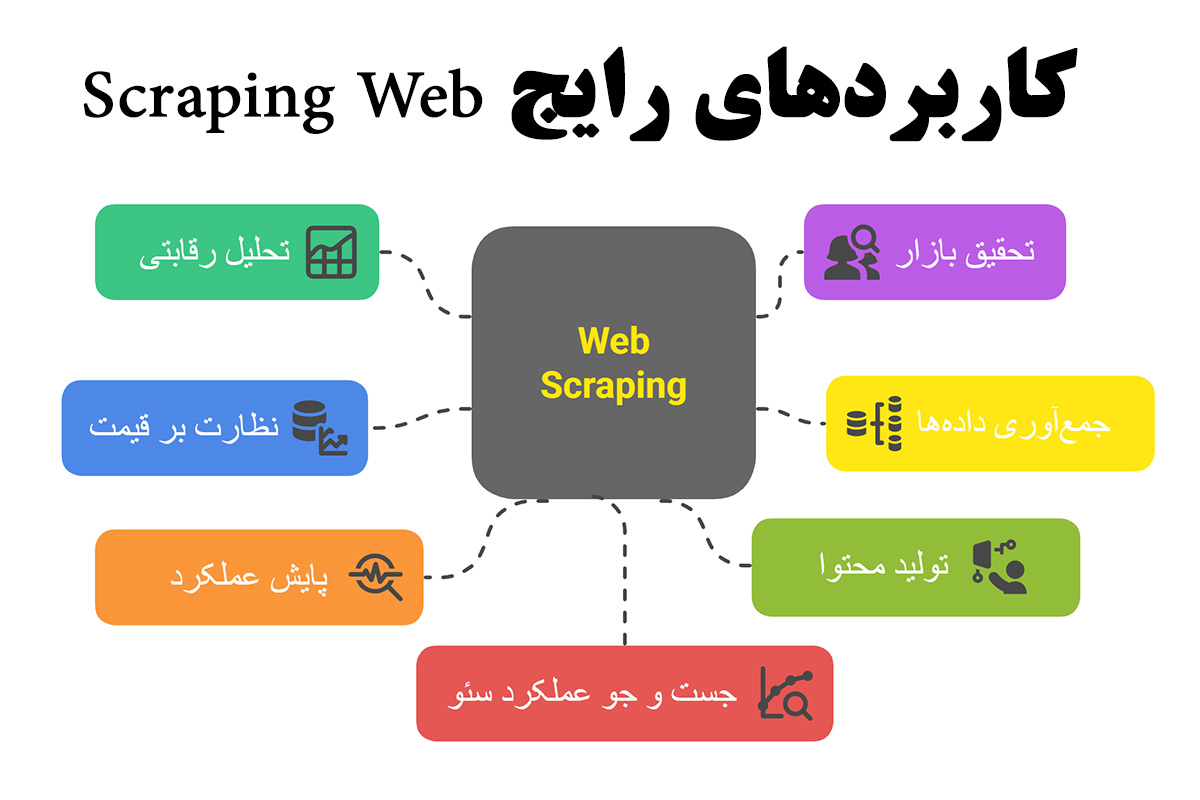

کاربردهای رایج Web Scraping

وب اسکرپینگ با پایتون برای اهداف مختلفی در جهت توسعه کسب و کارها و سازمانهای مختلف انجام میشود. با این روش، میتوان دادههای مختلفی را از سایتهای عمومی استخراج کرده و برای تحلیل و گرفتن تصمیمات حیاتی، به کار برد. در ادامه به برخی از کاربردهای رایج این روش استخراج داده اشاره میکنیم.

- دسترسی به قیمت کالاهای رقیب برای تصمیم گیری در بخش قیمت گذاری

- دسترسی به انبوه اطلاعات و دادهها با هدف تحقیق بازار در حوزههای مختلف

- استفاده از وب اسکرپینگ برای پایش اطلاعات و محتواهای خبری

- پایش عملکرد شرکت یا برند خاصی توسط وب اسکرپینگ

- جمع آوری و استخراج دادههای مربوط به کسب و کار خود

- جست و جو عملکرد سئو

- تجزیه و تحلیل رقبا و مدیریت درست خطر

چرا از پایتون برای وب اسکرپینگ استفاده میشود؟

انجام وب اسکرپینگ با پایتون که یکی از محبوبترین زبانهای برنامه نویسی است، به دلیل ویژگیها و مزیتهای این برنامه میباشد. این مزیتها باعث گستردگی کاربردهای پایتون در دنیای تکنولوژی شده که برخی از آنها شامل طراحی سایت با پایتون و حتی هک با پایتون نیز میباشد. در ادامه به بررسی مهمترین عوامل که باعث کاربرد این زبان در وب اسکرپینگ شده است، میپردازیم. برای آموزش کامل پایتون، میتوانید در دورههای تخصصی مجموعه دیتایاد شرکت کنید. در این مجموعه، تمام نکات لازم به صورت تخصصی در مورد پایتون، آموزش داده میشود.

مزایای پایتون در پردازش دادهها

استفاده از وب اسکرپینگ با پایتون به دلیل مزیتهای زیادی است که در این زبان برنامه نویسی وجود دارد. از مهمترین این مزیتها، میتوان به موارد زیر اشاره کرد.

- دارای قدرت بالا و کاربرد آسان: پایتون به عنوان یک زبان ساده و مبتدی در نظر گرفته شده که هر فرد تازه کاری، میتواند از آن استفاده کند. مدت زمان اجرای کدهای مختلف در این برنامه نسبت به سایر زبانهای برنامه نویسی، راحتتر و سریعتر است. این مزیت باعث افزایش سرعت در تجزیه تحلیل داده و توسعه نرم افزارها میشود.

- تنوع طرحهای گرافیکی و تجسمی بالا: در این زبان برنامه نویسی از طرحهای گرافیکی متنوعی استفاده شده است. این قابلیت باعث میشود تا بتوان اطلاعات و دادهها را به صورت نمودار و شکلهای گرافیکی مختلف، نمایش داد. در این برنامه، کتابخانههای ggplot، pandas plotting، pytorch و بسیاری از موارد دیگر برای ایجاد طرح و نمودارهای گرافیکی وجود دارد.

کتابخانههای محبوب پایتون برای Web Scraping

انجام وب اسکرپینگ با پایتون، توسط کتابخانههای موجود در این برنامه انجام میشود که تنوع بالایی نیز دارند. مهمترین کتابخانههای پایتون شامل موارد زیر هستند.

- MechanicalSoup: از این کتابخانه برای تعامل با فرمهای HTML استفاده میشود که قابلیت شبیه سازی رفتار انسان را دارد. حتی میتوان تعامل بین یک مرورگر و یک وب سایت را با این کتابخانه، کاملاً خودکار کرد.

- Requests: یکی از کتابخانههای ساده ولی قدرتمند پایتون به شمار میآید که برای ارسال درخواستهای HTTP استفاده میشود. در این کتابخانه، با استفاده از یک API ساده، میتوان درخواستهای GET و POST را ارسال کرده و بسیاری از فرایندها مثل احراز هویت، مدیریت کوکیها و سایر ویژگیهای HTTP را انجام داد. سادگی و راحتی استفاده از این کتابخانه باعث کاربرد گسترده آن در وب اسکرپینگ شده است.

- Selenium: کاربرد این کتابخانه برای تبدیل عملکرد مرورگرهای وب مانند Chrome، Firefox و Safari، به صورت خودکار میباشد. با این روش، میتوان تعامل انسان با سایتهای مختلف را در مرورگرها شبیه سازی کرد. برای تست کردن انواع برنامههای وب و انجام کارهای تکراری نیز این کتابخانه دارای کاربرد بسیار بالایی است.

- Pandas: با این کتابخانه، قابلیت ذخیره سازی اطلاعات و دستکاری آنها در قالبهای مختلفی مثل CSV، Excel، JSON و پایگاههای داده SQL وجود دارد. تمام دادههای استخراج شده از وب سایتها در روش وب اسکریپت را میتوان با این کتابخانه، تبدیل، تجزیه و تحلیل کرد.

آموزش وب اسکرپینگ با پایتون

انجام وب اسکرپینگ (Web Scraping) با پایتون باید طبق مراحل خاص و با بررسیهای لازم انجام شود. در ابتدا باید به بررسی ساختار سایتی که قرار است اطلاعات و دادههای آن استخراج شوند، پرداخت. با بررسی کد HTML صفحه مورد نظر، عناصر و اطلاعات مورد نیاز را شناسایی میکنیم. حال باید تکها و ویژگیهای مرتبط با آنها را مشخص کرد تا بتوان اطلاعات لازم را از طریق وب اسکرپینگ، استخراج کرد.

- قبل از استخراج اطلاعات از سایت با پایتون باید نسبت به نصب این زبان برنامه نویسی روی سیستم خود مطمئن بود. بعد از آماده شدن برنامه پایتون روی سیستم، حال باید یک فضای مجازی برای استخراج اطلاعات مورد نظر ایجاد کرد.

- در ادامه نوبت به انتخاب نرم افزارها یا همان کتابخانههای موجود در برنامه پایتون میرسد. بهترین کتابخانهها برای کسانی که مبتدی هستند، Requests و BeautifulSoup میباشند. این کتابخانهها با طراحی ساده و کاربردی خود، به مخاطب این امکان را میدهند تا استخراج داده را در کمترین زمان ممکن، اجرا کنند.

- در برخی از سایتها، ممکن است اطلاعات مورد نیاز در چندین صفحه مختلف، پراکنده باشند. در چنین شرایطی برای مدیریت بهتر اطلاعات و دادهها، میتوان از ابزار یا کتابخانه Selenium استفاده کرد. به کمک این نرم افزار، امکان مدیریت صفحات مختلف و طبقه بندی اطلاعات موجود در سایتها به راحتی قابل انجام است.

معرفی کتابخانه BeautifulSoup

اصلیترین مراحل کار در وب اسکرپینگ با پایتون، توسط کتابخانههایی که در این زبان برنامه نویسی وجود دارند، انجام میشود. یکی از بهترین کتابخانههای این زبان نیز BeautifulSoup است که جهت استخراج دادهها از فایلهای HTML و XML به کار میرود. هدف اصلی از کاربرد این کتابخانه، راحت کردن مراحل کار وب اسکرپینگ است. این کتابخانه به کاربران این امکان را میدهد تا اطلاعات مختلفی را از صفحات وب استخراج کرده و با توجه به نیاز خود، استفاده کنند. از ویژگیهای اصلی این کتابخانه، میتوان به موارد زیر اشاره کرد.

- دارای سازگاری بالا با انواع پارسرهای مختلف: پشتیبانی این کتابخانه از پارسرهایی مثل HTML parser، lxml و html5lib باعث میشود تا بتوان بهترین پارسر را با توجه به نیاز خود، انتخاب کرد.

- پیمایش آسان درخت سند (DOM): با استفاده از این کتابخانه، پیمایش درخت سند Document Object Model برای دسترسی به عناصر و اطلاعات مورد نیاز، بسیار راحت میشود.

- دارای قابلیت جستجوی قدرتمند: با بهکارگیری این کتابخانه، جستجو در اسناد HTML و XML بر اساس معیارهای مشخص و دقیق مثل نام، تک، آی دی و بسیاری از مشخصات دقیق دیگر امکان پذیر است. نتیجه این جستجوها نیز دسترسی به اطلاعات گسترده و مشخص خواهد بود.

- قابلیت تغییر ساختار HTML: یکی دیگر از ویژگیهای کتابخانه BeautifulSoup، قابلیت تغییر ساختار HTML، حذف و اضافه کردن تکها و ویرایش محتوای تگها میباشد.

استفاده از Requests برای ارسال درخواستها

یکی دیگر از کتابخانههای پرکاربرد در وب اسکرپینگ با پایتون، Requests است. با ایجاد استانداردهایی مشخص توسط این کتابخانه، تمام درخواستهایی که بر پایه HTTP هستند، به صورت خودکار دریافت و ارسال خواهند شد. برای ارسال انواع درخواستهای HTTP در این کتابخانه، از عبارتهای مختلفی طبق الگوهای زیر استفاده میشود.

- GET برای دریافت داده از یک URL

- POSTبرای ارسال داده

- PUT برای به روز رسانی دادهها

- DELETE برای حذف دادهها

- PATCH برای به روزرسانی جزئی دادهها

مثال عملی: استخراج اطلاعات از یک سایت ساده

در روش استخراج اطلاعات وب اسکرپینگ با پایتون باید از کتابخانههای مخصوص این نرم افزار استفاده کرد که کاربردیترین آن، کتابخانه Scrapy میباشد. این کتابخانه دارای ساختاری ساده است که میتواند با خزش سریع در انواع صفحات سایت، اطلاعات و دادههای لازم را استخراج کند. مراحل استخراج داده با کتابخانه scrapy، به صورت زیر است.

- ابتدا سایتی که قرار است اطلاعات یا دادههای آن را استخراج کنیم، مشخص میشود. برای مثال، قصد جمع آوری اطلاعات از سایت ایسنا را داریم. حال برنامه اسکرپی را نصب کرده و کد scrapy startproject isna_crawler را وارد میکنیم تا ساختار اولیه ایجاد شود.

- بعد از وارد کردن کد، برنامه اسکرپی به ما یک خروجی میدهد که نمونه کد آن به صورت زیر است:

C:\Users\Mojtaba\>scrapy startproject isna_crawler

۲۰۱۶-۰۵-۲۲ ۰۳:۳۷:۱۹ [scrapy] INFO: Scrapy 1.0.3 started (bot: scrapybot)

۲۰۱۶-۰۵-۲۲ ۰۳:۳۷:۱۹ [scrapy] INFO: Optional features available: ssl, http11, boto

۲۰۱۶-۰۵-۲۲ ۰۳:۳۷:۱۹ [scrapy] INFO: Overridden settings: {}

New Scrapy project ‘isna_crawler’ created in:

C:\Users\Mojtaba\\isna_crawler

You can start your first spider with:

cd isna_crawler

scrapy genspider example example.com

در داخل کد بالا، یک پوشه با نام isna_crawler ایجاد شده که محتوای داخل آن به صورت زیر میباشد.

├── cfg

└── isna_crawler

├── __py

├── py

├── py

├── py

└── spiders

└── __py

- هر کدام از این فایلها دارای اطلاعات مخصوص به خود هستند که اصلیترین آن، فایل py میباشد. در این فایل، ساختار تمام دادههایی که باید از صفحات سایت مورد نظر استخراج شوند، مشخص شده است. سایر فایلها شامل تنظیمات برنامه، محل قرارگیری فایل تنظیمات و انجام کارهای حرفهای است که به آنها کاری نداریم.

نکات مهم و قوانین وب اسکرپینگ

با توجه به قوانین کپی رایتینگ، سؤالی که شاید در ذهن بسیاری از افراد در خصوص وب اسکرپینگ با پایتون برسد، این است که انجام این کار قانونی است؟ در صورت استفاده مشروع از اطلاعات و دادهها و رعایت قوانین کپی رایتینگ، انجام وب اسکرپینگ هیچ مشکل و ایرادی نخواهد داشت. به صورت کلی، قانونی و غیر قانونی بودن وب اسکرپینگ به نحوه استفاده از اطلاعات استخراج شده بستگی دارد. اگر از اطلاعات استخراج شده یک سایت، استفادههای غیر قانونی شود، احتمال شکایت و برخوردهای قضایی وجود دارد.

آیا شما هم میخواهید با پایتون وارد دنیای تکنولوژی شوید؟

در دورههای پروژه محور دیتایاد، تحت عنوان دوره جامع نخبگان پایتون شرکت کنید. با یادگیری نکات لازم در این دوره، میتوانید کاربردهای واقعی پایتون در تکنولوژی را یاد گرفته و مسیر شغلی خود را بسازید. برای مشاوره رایگان میتوانید با شماره ۰۹۹۰۵۵۰۱۹۹۸ تماس بگیرید.

سؤالات متداول

1-بهترین کتابخانه برای وب اسکرپینگ در پایتون چیست؟

برای انجام وب اسکرپینگ با پایتون، کتابخانههای مختلفی استفاده میشوند که کاربردیترین آن، کتابخانه Scrapy است. این کتابخانه با ساختار ساده و بهینهای که دارد، میتواند اطلاعات لازم را در کمترین زمان ممکن و با دقت، استخراج کند.

2-تفاوت BeautifulSoup و Scrapy چیست؟

هر دو این کتابخانهها برای استخراج دادهها در وب اسکرپینگ با پایتون استفاده میشوند. تفاوت این دو، در عملکرد آنها هنگام جمع آوری دادهها است. نمونه scrapy با توجه به سرعت بالا، قابلیت جمع آوری اطلاعات از صفحات مختلف سایت را دارد. برنامه BeautifulSoup نیز از سرعت و سادگی لازم برخوردار است ولی معمولا برای جمع آوری اطلاعات از یک صفحه مشخص استفاده میشود.

3-آیا برای Web Scraping نیاز به دانش برنامهنویسی پیشرفته داریم؟

برای انجام وب اسکرپینگ (Web Scraping) با پایتون یا همان استخراج داده یا داده کاوی، نیاز به دانش برنامه نویسی نیست. چون انجام این کار با کمک پایتون نیز قابل اجراست. پایتون یکی از زبانهای ساده برنامه نویسی میباشد که دارای کتابخانههای مختلف برای استخراج دادههاست.

4-چطور با پایتون اطلاعات سایتهای پویا (JavaScript) را استخراج کنیم؟

کار وب اسکرپینگ با پایتون، توسط کتابخانههای موجود در این نرم افزار انجام میشود. تعداد این کتابخانهها بسیار زیادند و هر کدام از آنها، قابلیت و ویژگیهای خاصی دارند. داخل متن مقاله به مهمترین آنها اشاره شده است.

5-مهمترین مزیتهای پایتون در استخراج و پردازش دادهها چیست؟

زبان برنامه نویسی پایتون دارای قابلیتهای بالایی در زمینه استخراج و پردازش دادهها است. قابلیتهای گسترده این برنامه به دلیل مزیتهای آن میباشد. مهمترین مزیتهای پایتون شامل: سادگی و خوانایی کد، دارای کتابخانههای متنوع، پشتیبانی از پارادایمهای مختلف برنامه نویسی، دارای جامعه کاربردی گسترده و فعال و همچنین قابلیت یادگیری آسان آن است.

4 پاسخ

عالی بود

خیلی خوشحالم که راضی بودی

کاربری و جامع

ممنون از لطفت