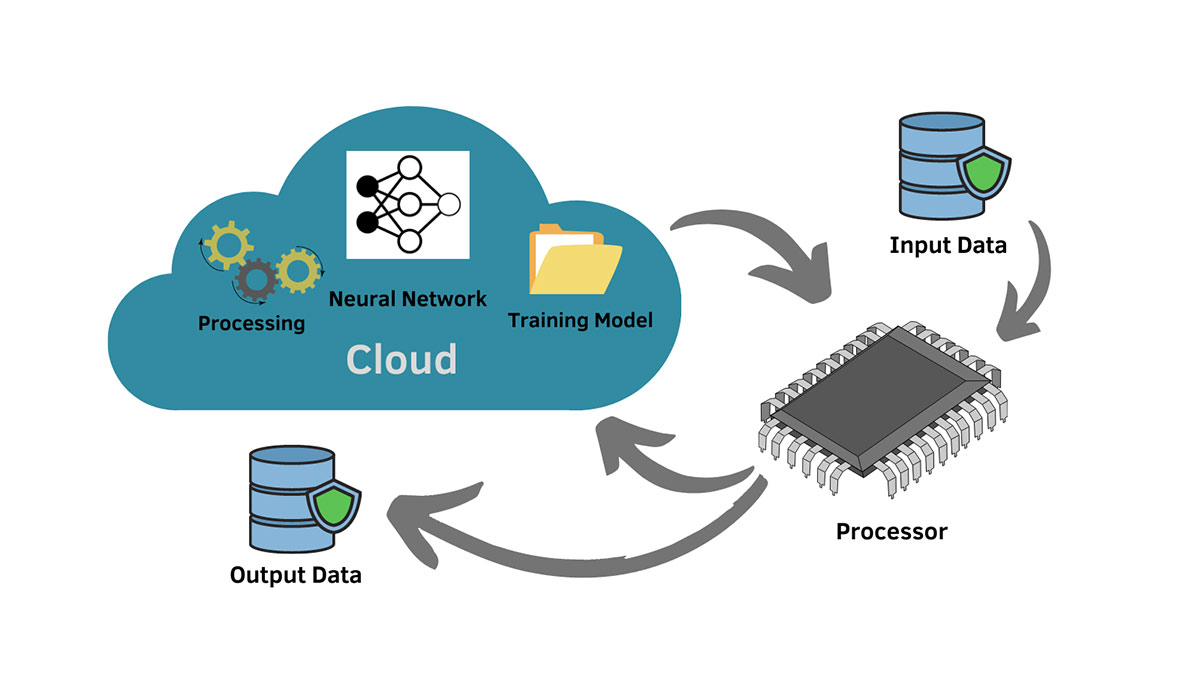

یادگیری ماشین مبتنی بر رایانش ابری (Cloud-based Machine Learning) رویکردی نوین است که به مهندسان داده، دانشمندان یادگیری ماشین و توسعهدهندگان هوش مصنوعی کمک میکند تا مدلهای خود را در مقیاس بسیار بزرگتر و با هزینه کمتر توسعه و پیادهسازی کنند. در این روش، بهجای تکیه بر سختافزار و سرورهای محلی، پردازش دادهها و آموزش مدلها در بستر زیرساختهای ابری مانند AWS، Google Cloud و Microsoft Azure انجام میشود.

یکی از بزرگترین مزایای این رویکرد، انعطافپذیری و مقیاسپذیری بالا است. سازمانها میتوانند تنها بهاندازه نیاز خود از منابع ابری استفاده کنند و در صورت افزایش حجم داده یا پیچیدگی مدلها، بهراحتی ظرفیت بیشتری به پروژه اختصاص دهند. علاوه بر این، سرویسهای ابری امکاناتی مانند AutoML، ابزارهای مدیریت داده، و استقرار سریع مدلها را فراهم میکنند که فرآیند توسعه هوش مصنوعی و یادگیری ماشین را بسیار سادهتر میسازد.

از آنجا که امروزه اکثر شرکتها در حال مهاجرت به فضای ابری هستند، ادغام رایانش ابری و یادگیری ماشین نه تنها یک انتخاب استراتژیک، بلکه یک ضرورت برای رقابت در دنیای دادهمحور محسوب میشود.

یادگیری ماشین مبتنی بر ابر به دلیل قابلیتهای زیرساختی و سرویسهای گسترده، بهسرعت جایگزین روشهای سنتی شده است. مهمترین مزایای این رویکرد عبارتاند از:

- مقیاسپذیری (Scalability): سازمانها میتوانند بدون نیاز به خرید سختافزار جدید، منابع پردازشی بیشتری به پروژههای ML خود اختصاص دهند. این ویژگی برای مدلهای پیچیده و مجموعهدادههای حجیم بسیار حیاتی است.

- هزینه بهینه (Cost Efficiency): در روش سنتی نیاز به خرید و نگهداری سرورهای قدرتمند وجود دارد، اما در رایانش ابری تنها بهاندازه مصرف، هزینه پرداخت میشود. این مدل پرداخت بهصورت Pay-as-you-go برای بسیاری از استارتاپها و کسبوکارهای کوچک مقرونبهصرفه است.

- دسترسی جهانی (Global Accessibility): اعضای تیم توسعه میتوانند از هر نقطه جهان به دادهها، مدلها و محیطهای آزمایشی دسترسی داشته باشند. این ویژگی بهویژه برای پروژههای بینالمللی و تیمهای ریموت ارزشمند است.

- یکپارچگی با سایر سرویسها: پلتفرمهای ابری بهطور پیشفرض امکاناتی مثل ذخیرهسازی داده، پردازش توزیعشده، ابزارهای تحلیل داده با پایتون، و سرویسهای هوش مصنوعی و یادگیری ماشین را فراهم میکنند.

- امنیت و پشتیبانگیری (Security & Backup): ارائهدهندگان ابر، امکانات امنیتی پیشرفته مانند رمزنگاری دادهها، کنترل دسترسی و بکاپ خودکار را فراهم میکنند که ریسک از دست رفتن داده یا حملات سایبری را کاهش میدهد.

مقایسه یادگیری ماشین سنتی و ابرمحور

برای درک بهتر اهمیت استفاده از ابر، باید تفاوتهای کلیدی آن با یادگیری ماشین سنتی بررسی شود:

|

ویژگیها |

یادگیری ماشین سنتی (On-premise ML) | یادگیری ماشین مبتنی بر ابر (Cloud ML) |

| زیرساخت | نیازمند خرید سرورهای فیزیکی و GPU قدرتمند |

منابع پردازشی منعطف و مقیاسپذیر در بستر ابر |

|

هزینه |

هزینه اولیه بالا + هزینه نگهداری مداوم | پرداخت بهازای مصرف (Pay-as-you-go) |

| مقیاسپذیری | محدود به ظرفیت سختافزار محلی |

امکان افزایش منابع با چند کلیک |

|

دسترسی |

محدود به شبکه داخلی | دسترسی جهانی برای تیمهای توزیعشده |

| پیچیدگی راهاندازی | نیازمند تیم IT و پشتیبانی سختافزاری |

پلتفرمهای آماده با سرویسهای از پیشساخته مانند AutoML |

|

زمان استقرار مدل |

طولانی به دلیل آمادهسازی زیرساخت | سریع و قابل استقرار به صورت سرویس (API) |

| یکپارچگی با دادهها | نیازمند انتقال و پردازش محلی |

اتصال مستقیم به سرویسهای ذخیرهسازی و پایگاهداده ابری |

به همین دلیل، بسیاری از سازمانها ترجیح میدهند به جای سرمایهگذاری سنگین در سختافزار، پروژههای خود را با کمک پلتفرمهای ML ابری اجرا کنند.

برای تبدیل این دانش به مهارتهای کاربردی، دورههای تخصصی یادگیری ماشین ما را ببینید.قبل از ثبتنام، مشاوره رایگان دریافت کنید؛ کافیست با شماره ۰۹۹۰۵۵۰۱۹۹۸ تماس بگیرید.

سرویسهای اصلی ML در پلتفرمهای ابری

پلتفرمهای ابری مختلف، سرویسهای تخصصی برای یادگیری ماشین ارائه میدهند که هدفشان سادهسازی و تسریع فرآیند آموزش، استقرار و مدیریت مدلها است. در این بخش، سه پلتفرم اصلی AWS، Google Cloud و Azure را بررسی میکنیم.

AWS SageMaker: قابلیتها و نمونه کد

Amazon SageMaker یکی از پرقدرتترین سرویسهای یادگیری ماشین در فضای ابری است. این سرویس یک محیط یکپارچه برای آمادهسازی داده، آموزش مدل، تنظیم هایپرپارامترها، و در نهایت استقرار مدل بهعنوان سرویس فراهم میکند.

ویژگیهای کلیدی:

- پشتیبانی از چارچوبهای محبوب مانند TensorFlow، PyTorch و Scikit-learn

- امکان استفاده از الگوریتمهای آماده یا نوشتن کد سفارشی

- قابلیت AutoML داخلی برای کاربران غیرتخصصی

- استقرار سریع مدلها از طریق Endpoint

نمونه کد ساده برای استقرار مدل در SageMaker (با پایتون):

import sagemaker

from sagemaker import get_execution_role

role = get_execution_role()

sess = sagemaker.Session()

# انتخاب الگوریتم آماده XGBoost

from sagemaker.amazon.amazon_estimator import get_image_uri

container = get_image_uri(sess.boto_region_name, 'xgboost')

xgb = sagemaker.estimator.Estimator(

container,

role,

instance_count=1,

instance_type='ml.m5.large',

output_path='s3://my-bucket/output',

sagemaker_session=sess

)

# آموزش مدل

xgb.fit({'train': 's3://my-bucket/train.csv'})

Google Vertex AI: آموزش مدل بدون زیرساخت

Google Vertex AI نسل جدید سرویسهای ML در Google Cloud است که جایگزین AI Platform شده است. این سرویس با هدف کاهش پیچیدگی و حذف نیاز به مدیریت زیرساخت ارائه شده است.

ویژگیهای کلیدی:

- آموزش مدلها بدون نیاز به نوشتن کد زیاد

- یکپارچه با BigQuery و Cloud Storage برای تحلیل دادهها

- سرویس AutoML بسیار قدرتمند برای طبقهبندی تصاویر، متن و دادههای جدولی با پشتیبانی از انواع الگوریتم های یادگیری ماشین

- داشبورد مدیریتی برای مانیتورینگ مدلها و دادهها

یکی از قابلیتهای جذاب Vertex AI، Pipeline است که امکان طراحی و اجرای کل چرخه ML (از آمادهسازی داده تا استقرار) را به صورت گرافیکی فراهم میکند.

Azure Machine Learning: ادغام با اکوسیستم مایکروسافت

Azure ML پلتفرم یادگیری ماشین مایکروسافت است که بهطور ویژه برای سازمانهایی طراحی شده که از اکوسیستم Microsoft (مانند Power BI، SQL Server و Dynamics 365) استفاده میکنند.

ویژگیهای کلیدی:

- ادغام کامل با Microsoft Power BI برای مصورسازی نتایج مدل

- رابط کاربری Drag & Drop برای کاربران غیرکدنویس

- پشتیبانی از چارچوبهای متنباز مانند PyTorch و TensorFlow

- قابلیت MLOps برای مدیریت چرخه عمر مدلها (از آموزش تا نگهداری و مانیتورینگ)

Azure ML این امکان را میدهد که مدلها به صورت مستقیم در اپلیکیشنهای سازمانی مایکروسافت مورد استفاده قرار گیرند؛ ویژگیای که برای شرکتهای بزرگ بسیار ارزشمند است.

مقایسه پلتفرمهای ابری برای ML

برای انتخاب بهترین پلتفرم ابری جهت پیادهسازی پروژههای یادگیری ماشین، باید عواملی مثل قیمتگذاری، پشتیبانی از فریمورکها، قابلیتهای AutoML و سطح ادغام با سایر سرویسها در نظر گرفته شود. جدول زیر یک دید کلی از سه پلتفرم اصلی AWS، GCP و Azure ارائه میدهد:

|

ویژگیها |

AWS SageMaker | Google Vertex AI | Azure Machine Learning |

| مدل قیمتگذاری | پرداخت بهازای مصرف (ساعت/پردازش) – هزینه GPU بالاتر است | پرداخت Pay-as-you-go + تخفیف برای استفاده طولانیمدت |

پرداخت منعطف، امکان رزرو منابع با هزینه کمتر |

|

پشتیبانی از فریمورکها |

TensorFlow، PyTorch، MXNet، Scikit-learn و الگوریتمهای اختصاصی آمازون | TensorFlow (بومی GCP)، PyTorch، Scikit-learn، XGBoost | TensorFlow، PyTorch، Scikit-learn، R و ادغام با ابزارهای مایکروسافت |

| قابلیت AutoML | دارد (Amazon SageMaker Autopilot) | بسیار پیشرفته (Google AutoML Vision, NLP, Tables) |

دارد (Azure AutoML) با رابط گرافیکی کاربرپسند |

|

ادغام با سایر سرویسها |

اتصال قوی به S3، Redshift، و سایر سرویسهای AWS | یکپارچگی با BigQuery، Cloud Storage، Dataflow |

ادغام کامل با Power BI، SQL Server، Microsoft 365 |

|

سهولت استفاده |

مناسب برای متخصصان فنی؛ کمی پیچیدهتر | رابط کاربری سادهتر؛ مناسب تیمهای داده و غیرتخصصی | رابط کاربری Drag & Drop برای کاربران غیرکدنویس |

| مزیت رقابتی اصلی | انعطافپذیری بالا و تنوع سرویسها | AutoML قدرتمند و حذف نیاز به زیرساخت |

MLOps و ادغام قوی با ابزارهای سازمانی مایکروسافت |

برای تبدیل این دانش به مهارتهای کاربردی، دورههای تخصصی یادگیری ماشین ما را ببینید.قبل از ثبتنام، مشاوره رایگان دریافت کنید؛ کافیست با شماره ۰۹۹۰۵۵۰۱۹۹۸ تماس بگیرید.

پیادهسازی عملی یک پروژه یادگیری ماشین در ابر

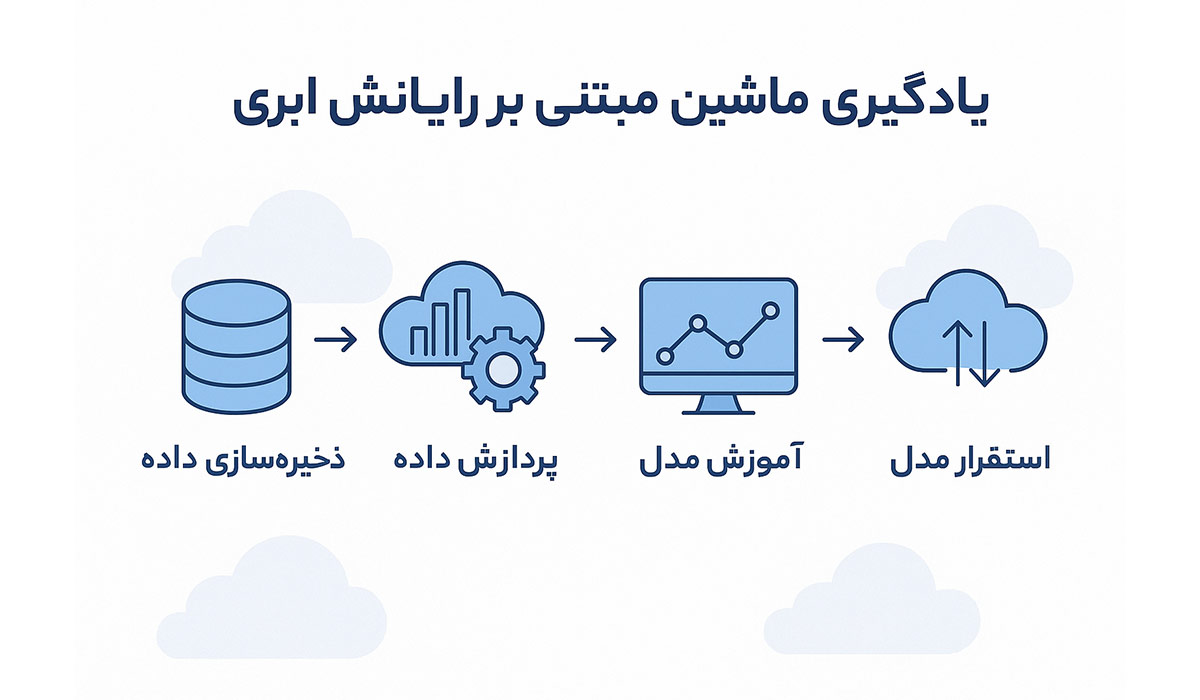

در این بخش، یک پروژه نمونه یادگیری ماشین را مرحله به مرحله در محیط ابری بررسی میکنیم. برای سادگی، مراحل را بر اساس معماری مشترک پلتفرمهای ابری (AWS، GCP و Azure) توضیح میدهیم.

مرحله ۱: آمادهسازی دادهها با Cloud Storage

اولین گام، جمعآوری و آمادهسازی دادههاست. دادهها باید در یک فضای ذخیرهسازی ابری بارگذاری شوند تا برای پردازش و آموزش در دسترس باشند.

- در AWS: دادهها در Amazon S3 بارگذاری میشوند.

- در Google Cloud: دادهها در Cloud Storage ذخیره میشوند.

- در Azure: از Blob Storage استفاده میشود.

در این مرحله کارهایی مثل پاکسازی داده، نرمالسازی، تقسیم داده به آموزش/اعتبارسنجی/تست و فرمتدهی فایلها (CSV، Parquet و …) انجام میشود.

نمونه کد آپلود داده در Google Cloud Storage با پایتون:

from google.cloud import storage

client = storage.Client()

bucket = client.bucket("my-ml-bucket")

# بارگذاری فایل CSV

blob = bucket.blob("dataset/train.csv")

blob.upload_from_filename("local_train.csv")

print("Upload completed!")

مرحله ۲: آموزش مدل با AutoML

پس از آمادهسازی داده، نوبت به آموزش مدل میرسد. در پلتفرمهای ابری، میتوان از سرویس AutoML استفاده کرد تا بدون نیاز به کدنویسی پیچیده، مدلهای دقیق ساخته شوند.

- در AWS SageMaker Autopilot: دادهها را وارد میکنید و SageMaker بهترین الگوریتم و هایپرپارامترها را انتخاب میکند.

- در Google Vertex AI AutoML: کافی است نوع داده (تصویر، متن یا جدولی) را مشخص کنید تا بهطور خودکار مدل آموزش داده شود.

- در Azure AutoML: امکان انتخاب معیار بهینهسازی (دقت، سرعت پیشبینی و …) وجود دارد.

استفاده از AutoML باعث میشود حتی افرادی که تجربه عمیق در طراحی الگوریتمها ندارند، بتوانند مدلهای با کیفیت تولید کنند.

مرحله ۳: استقرار مدل به عنوان سرویس

پس از آموزش، مدل باید بهصورت سرویس تحت وب (API) مستقر شود تا سایر اپلیکیشنها و کاربران بتوانند از آن استفاده کنند.

- در AWS: مدل در قالب Endpoint در دسترس قرار میگیرد.

- در Google Vertex AI: با چند کلیک میتوان مدل را روی یک Endpoint REST API مستقر کرد.

- در Azure ML: امکان انتشار مدل روی Azure Kubernetes Service (AKS) یا Azure Container Instances (ACI) وجود دارد.

نمونه کد برای استقرار مدل در Vertex AI (پایتون):

from google.cloud import aiplatform

model = aiplatform.Model("projects/12345/locations/us-central1/models/987654")

endpoint = model.deploy(

machine_type="n1-standard-4",

traffic_split={"0": 100}

)

print("Model deployed at endpoint:", endpoint.resource_name)

بعد از استقرار، میتوان بهراحتی از طریق API درخواست پیشبینی (Prediction Request) ارسال کرد.

چالشها و راهکارهای یادگیری ماشین ابری

با وجود مزایای گسترده، یادگیری ماشین مبتنی بر رایانش ابری بدون چالش نیست. سازمانها هنگام استفاده از این رویکرد با موانعی روبهرو میشوند که باید برای آنها راهکار مناسب در نظر گرفت.

۱. هزینههای پیشبینینشده

اگرچه مدل پرداخت Pay-as-you-go انعطافپذیر است، اما در پروژههای بزرگ با حجم داده بالا ممکن است هزینهها فراتر از انتظار برود.

راهکار: استفاده از ابزارهای مانیتورینگ هزینه (Cost Management) و تعیین سقف بودجه برای هر پروژه.

۲. امنیت و محرمانگی دادهها

انتقال دادههای حساس (مانند دادههای پزشکی یا مالی) به فضای ابری ممکن است نگرانیهای امنیتی ایجاد کند.

راهکار: استفاده از رمزنگاری دادهها، کنترل دسترسی مبتنی بر نقش (RBAC)، و ذخیره دادهها در مناطق جغرافیایی امن.

۳. قفل شدن به فروشنده (Vendor Lock-in)

وقتی یک سازمان کل پروژه ML خود را روی یک پلتفرم خاص اجرا کند، مهاجرت به پلتفرم دیگر دشوار میشود.

راهکار: استفاده از چارچوبها و ابزارهای متنباز (مثل TensorFlow، PyTorch) و طراحی معماری منعطف برای کاهش وابستگی.

۴. مدیریت دادههای حجیم (Big Data Management)

ذخیرهسازی و پردازش مجموعه دادههای عظیم میتواند زمانبر و پرهزینه باشد.

راهکار: استفاده از سرویسهای پردازش توزیعشده مانند Apache Spark روی محیط ابری و بهینهسازی Pipeline داده.

۵. پیچیدگی در استقرار و نگهداری مدلها

هرچند سرویسهای AutoML فرآیند آموزش را ساده کردهاند، اما استقرار و نگهداری مدلها (MLOps) همچنان چالشبرانگیز است.

راهکار: استفاده از ابزارهای MLOps موجود در پلتفرمها (مانند SageMaker Pipelines، Vertex AI Pipelines و Azure ML Ops) برای خودکارسازی استقرار، نسخهبندی و مانیتورینگ مدلها.

بهطور کلی، آگاهی از این چالشها و بهکارگیری راهکارهای مناسب میتواند موجب شود سازمانها بهترین بهرهوری را از رایانش ابری و یادگیری ماشین به دست آورند.

آینده یادگیری ماشین مبتنی بر ابر

یادگیری ماشین ابری بهسرعت در حال تبدیل شدن به ستون اصلی توسعه هوش مصنوعی در مقیاس سازمانی است. روندهای آینده نشان میدهند که استفاده از این فناوری نهتنها گستردهتر، بلکه هوشمندانهتر خواهد شد.

۱. افزایش استفاده از AutoML و ابزارهای بدون کدنویسی

با پیشرفت سرویسهای AutoML، حتی افراد غیرمتخصص هم قادر خواهند بود مدلهای یادگیری ماشین را طراحی و مستقر کنند. این روند باعث میشود دموکراتیکسازی هوش مصنوعی شتاب بیشتری بگیرد.

۲. ادغام عمیقتر با اینترنت اشیاء (IoT)

با گسترش دستگاههای IoT، نیاز به پردازش و تحلیل دادهها در زمان واقعی افزایش مییابد. پلتفرمهای ابری ML بهطور فزایندهای برای پردازش این دادهها در لبه شبکه (Edge Computing) بهکار گرفته خواهند شد.

۳. پیشرفت در MLOps و مدیریت چرخه عمر مدل

در آینده، مدیریت مدلها (از آموزش تا نگهداری و مانیتورینگ) بهصورت خودکارتر انجام خواهد شد. ابزارهای MLOps پیشرفتهتر، مشکلاتی مثل Drift داده یا افت دقت مدل را سریعتر شناسایی و رفع خواهند کرد.

۴. کاهش وابستگی به فروشندگان خاص (Multi-cloud & Hybrid Cloud)

سازمانها به سمت معماریهای چندابری (Multi-cloud) و ابر ترکیبی (Hybrid Cloud) حرکت میکنند تا از وابستگی به یک ارائهدهنده خاص جلوگیری کرده و انعطافپذیری بیشتری به دست آورند.

۵. همگرایی هوش مصنوعی و یادگیری ماشین با سایر فناوریها

یادگیری ماشین ابری بیشازپیش با حوزههایی مانند بلاکچین، کلانداده و واقعیت افزوده/مجازی ادغام خواهد شد و فرصتهای جدیدی برای نوآوری ایجاد خواهد کرد.

بهطور خلاصه، آینده یادگیری ماشین مبتنی بر ابر، آیندهای چابکتر، مقیاسپذیرتر و فراگیرتر خواهد بود که در آن مرز بین علم داده و کسبوکار روزبهروز کمتر میشود

نتیجهگیری

یادگیری ماشین مبتنی بر رایانش ابری، مسیر توسعه مدلهای هوشمند را برای سازمانها سادهتر، سریعتر و مقیاسپذیرتر کرده است. ترکیب رایانش ابری و یادگیری ماشین نهتنها هزینهها را کاهش میدهد، بلکه دسترسی جهانی، امنیت بالا و یکپارچگی با سایر فناوریها را نیز به همراه دارد. همچنین، ابزارهایی مانند تحلیل داده با پایتون نقش مهمی در آمادهسازی و پردازش دادهها قبل از آموزش مدلهای ابری ایفا میکنند و به متخصصان کمک میکنند تا از تمام ظرفیتهای رایانش ابری بهرهبرداری کنند.

برای تبدیل این دانش به مهارتهای کاربردی، دورههای تخصصی یادگیری ماشین ما را ببینید.قبل از ثبتنام، مشاوره رایگان دریافت کنید؛ کافیست با شماره ۰۹۹۰۵۵۰۱۹۹۸ تماس بگیرید.

سوالات متداول

۱. مزیت اصلی استفاده از رایانش ابری برای یادگیری ماشین چیست؟

بزرگترین مزیت، مقیاسپذیری و کاهش هزینهها است. شما میتوانید تنها بهاندازه نیاز از منابع پردازشی استفاده کنید و هر زمان که پروژه گسترش پیدا کرد، منابع بیشتری در اختیار بگیرید.

۲. آیا برای استفاده از یادگیری ماشین ابری نیاز به تخصص فنی بالاست؟

نه الزاماً. بسیاری از پلتفرمها مثل Google Vertex AI و Azure ML ابزارهای AutoML و محیطهای Drag & Drop ارائه میدهند که برای کاربران غیرمتخصص هم مناسب است. با این حال، داشتن دانش پایه در زمینه الگوریتم های یادگیری ماشین و تحلیل داده با پایتون میتواند کارایی شما را افزایش دهد.

۳. چگونه امنیت دادهها در پروژههای ML ابری تضمین میشود؟

پلتفرمهای ابری بزرگ مانند AWS، GCP و Azure از روشهایی مثل رمزنگاری دادهها، کنترل دسترسی (IAM) و پشتیبانگیری خودکار استفاده میکنند. علاوه بر این، کاربران میتوانند منطقه جغرافیایی ذخیره داده را انتخاب کنند تا قوانین محلی رعایت شود.

۴. کدام پلتفرم برای شروع بهتر است؟

انتخاب پلتفرم بستگی به نیاز شما دارد:

- اگر سازمانتان روی اکوسیستم مایکروسافت سرمایهگذاری کرده → Azure

- اگر دنبال سادهترین راه برای شروع بدون زیرساخت هستید → Google Vertex AI

- اگر به انعطافپذیری بالا و تنوع سرویسها نیاز دارید → AWS SageMaker

۵. آیا میتوان یادگیری ماشین ابری را با پروژههای هوش مصنوعی و یادگیری ماشین ترکیب کرد؟

بله. در حقیقت، رایانش ابری یکی از مهمترین محرکهای رشد هوش مصنوعی و یادگیری ماشین است، چون امکان دسترسی به دادههای عظیم، محاسبات سنگین و استقرار مقیاسپذیر را فراهم میکند.