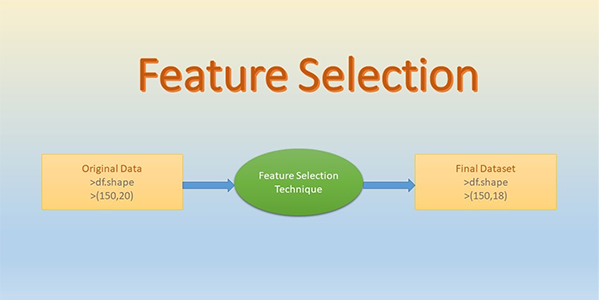

انتخاب ویژگی (Feature Selection) یکی از مهمترین مراحل در یادگیری ماشین و دادهکاوی است که تأثیر مستقیم بر عملکرد و دقت مدلهای پیشبینی دارد. هدف اصلی از انتخاب ویژگی، شناسایی و نگه داشتن آن دسته از ویژگیها (Variables) است که بیشترین اطلاعات را دربارهی هدف مدل ارائه میدهند و حذف ویژگیهای غیرمؤثر یا نویزی باعث کاهش پیچیدگی مدل، بهبود سرعت آموزش و افزایش دقت پیشبینی میشود.

استفاده از روشهای انتخاب ویژگی در یادگیری ماشین به پژوهشگران و مهندسان داده کمک میکند تا مدلهای سبکتر، سریعتر و قابل فهمتری بسازند. این فرآیند به ویژه در دادههای با ابعاد بالا و پیچیده اهمیت ویژهای دارد، جایی که وجود تعداد زیادی ویژگی غیرمؤثر میتواند باعث Overfitting یا کاهش دقت مدل شود.

برای دانشجویان و پژوهشگران حوزه دادهکاوی، درک و پیادهسازی عملی روشهای انتخاب ویژگی یک مهارت کلیدی است که میتواند به بهینهسازی مدلهای هوش مصنوعی و یادگیری ماشین کمک کند.

انتخاب ویژگی چیست و چرا حیاتی است؟

انتخاب ویژگی (Feature Selection) فرآیندی است که طی آن مجموعهای از ویژگیها از دادههای اصلی انتخاب میشوند تا مدل نهایی بر اساس آنها ساخته شود. این انتخاب به بهبود عملکرد مدل، کاهش پیچیدگی و افزایش قابلیت تفسیر کمک میکند.برای دانشجویان و پژوهشگران علاقهمند به یادگیری عملی انتخاب ویژگی، میتوانید از آموزش رایگان یادگیری ماشین با پایتون استفاده کنید تا مهارتهای عملی خود را تقویت نمایید.

مزایای انتخاب ویژگی در کاهش ابعاد داده

- افزایش دقت مدل: حذف ویژگیهای غیرمؤثر باعث کاهش نویز و جلوگیری از Overfitting میشود.

- کاهش زمان آموزش: با کاهش تعداد ویژگیها، مدل سریعتر آموزش داده میشود.

- قابلیت تفسیر بهتر: مدلهای سادهتر راحتتر قابل درک و تحلیل هستند.

- صرفهجویی در منابع محاسباتی: دادههای کوچکتر نیاز به حافظه و پردازش کمتری دارند.

یکی از نکات مهم این است که انتخاب ویژگی متفاوت از کاهش ابعاد (Dimensionality Reduction) است؛ در کاهش ابعاد معمولاً ویژگیها ترکیب میشوند تا ویژگیهای جدید ساخته شود (مثل PCA)، اما در انتخاب ویژگی، خود ویژگیها یا حذف میشوند یا نگه داشته میشوند.

برای دریافت راهنمایی تخصصی در انتخاب بهترین دوره آموزشی متناسب با نیازتان، کارشناسان آموزشی ما آماده پاسخگویی و مشاوره هستند. با شماره ۰۹۹۰۵۵۰۱۹۹۸ ارتباط بگیرید.

به نقل از سایت geeksforgeeks:

«شامل انتخاب زیرمجموعهای از ویژگیهای مرتبط از مجموعه ویژگیهای اصلی برای کاهش فضای ویژگی و در عین حال بهبود عملکرد مدل با کاهش قدرت محاسباتی است. هنگامی که یک مجموعه داده ویژگیهای زیادی دارد، برخی ممکن است نامربوط باشند یا نویز ایجاد کنند که میتواند روند آموزش را کند کرده و دقت را کاهش دهد، اما به ساخت مدلهای سادهتر، سریعتر و دقیقتر کمک میکند و همچنین به کاهش بیشبرازش کمک میکند.»

انواع روشهای انتخاب ویژگی

روشهای انتخاب ویژگی به سه دسته اصلی تقسیم میشوند که هر کدام مزایا و کاربردهای خاص خود را دارند:

- روشهای فیلتری (Filter Methods)

- روشهای پیچیده (Wrapper Methods)

- روشهای توکار (Embedded Methods)

روشهای فیلتری (Filter Methods)

روشهای فیلتری بر اساس ویژگیهای آماری و معیارهای مستقل از مدل تصمیم میگیرند که کدام ویژگیها نگه داشته شوند یا حذف شوند. این روشها سریع هستند و برای دادههای بزرگ مناسباند.

مثالها:

- Correlation Coefficient: بررسی همبستگی بین هر ویژگی و هدف مدل. ویژگیهایی با همبستگی پایین حذف میشوند.

- Chi-Square Test: بررسی رابطه بین ویژگیها و متغیر هدف دستهای.

- ANOVA F-test: برای دادههای عددی و دستهای، بررسی تفاوت میانگین بین گروهها.

مزایا: سرعت بالا و مستقل از مدل

معایب: ممکن است روابط پیچیده بین ویژگیها نادیده گرفته شود

روشهای پیچیده (Wrapper Methods)

روشهای پیچیده از یک الگوریتم پیشبینی به عنوان ارزیاب برای انتخاب بهترین زیرمجموعه ویژگیها استفاده میکنند. این روشها معمولاً دقت بالاتری دارند اما محاسباتیتر و زمانبر هستند.

مثالها:

- Forward Selection: شروع با هیچ ویژگی، اضافه کردن ویژگیها یکییکی و ارزیابی مدل

- Backward Elimination: شروع با همه ویژگیها، حذف ویژگیها به صورت مرحلهای و ارزیابی مدل

- Recursive Feature Elimination (RFE): حذف مکرر ویژگیهای کماهمیت با توجه به اهمیت در مدل

مزایا: دقت بالاتر و در نظر گرفتن تعامل بین ویژگیها

معایب: زمانبر و نیازمند منابع محاسباتی بیشتر

روشهای توکار (Embedded Methods)

روشهای توکار ویژگیها را در حین آموزش مدل انتخاب میکنند. این روشها تعادلی بین سرعت و دقت ارائه میدهند.

مثالها:

- Lasso Regression (L1 Regularization): وزن ویژگیهای کماهمیت را صفر میکند

- Decision Tree / Random Forest: اهمیت ویژگیها را محاسبه میکند و ویژگیهای غیرمهم حذف میشوند

- Gradient Boosting Methods: انتخاب ویژگی به صورت داخلی انجام میشود

مزایا: سریعتر از Wrapper و دقیقتر از Filter

معایب: وابسته به مدل انتخابشده

مقایسه روشهای انتخاب ویژگی (جدول مقایسهای کارایی روشها)

|

نوع روش |

مثالها | مزایا | معایب | کاربرد |

| روشهای فیلتری (Filter Methods) | Correlation, Chi-Square, ANOVA F-test | سریع، مستقل از مدل، مناسب دادههای بزرگ | نادیده گرفتن تعامل بین ویژگیها، دقت کمتر نسبت به Wrapper |

پیشپردازش اولیه، کاهش سریع ابعاد داده |

|

روشهای پیچیده (Wrapper Methods) |

Forward Selection, Backward Elimination, RFE | دقت بالا، در نظر گرفتن تعامل بین ویژگیها | زمانبر، نیازمند منابع محاسباتی زیاد | دادههای کوچک تا متوسط، زمانی که دقت مدل اهمیت دارد |

| روشهای توکار (Embedded Methods) | Lasso Regression, Decision Tree, Random Forest, Gradient Boosting | ترکیبی از سرعت و دقت، انتخاب ویژگی در حین آموزش مدل | وابسته به مدل انتخابشده، ممکن است تعمیمپذیری محدود شود |

مدلهایی که قابلیت انتخاب ویژگی داخلی دارند، بهبود مدل نهایی |

این جدول به شما کمک میکند بهترین روش انتخاب ویژگی را با توجه به اندازه داده، منابع محاسباتی و دقت مورد انتظار انتخاب کنید.

پیادهسازی عملی در پایتون

برای پیادهسازی انتخاب ویژگی در پایتون، معمولاً از کتابخانهی پایتون مانندScikit-learn استفاده میشود. این کتابخانه ابزارهای متنوعی برای روشهای Filter، Wrapper و Embedded ارائه میدهد.

انتخاب ویژگی با Scikit-learn

1. روشهای فیلتری (Filter Methods)

from sklearn.datasets import load_iris

from sklearn.feature_selection import SelectKBest, chi2

# بارگذاری دیتاست نمونه

data = load_iris()

X, y = data.data, data.target

# انتخاب بهترین 2 ویژگی با Chi-Square

selector = SelectKBest(chi2, k=2)

X_new = selector.fit_transform(X, y)

print("ویژگیهای منتخب:\n", X_new[:5])

توضیح:

- SelectKBest برای انتخاب k ویژگی برتر بر اساس معیار آماری استفاده میشود.

- chi2 یکی از معیارهای فیلتری برای دادههای دستهای است.

2. روشهای پیچیده (Wrapper Methods)

from sklearn.feature_selection import RFE

from sklearn.ensemble import RandomForestClassifier

# مدل پایه

model = RandomForestClassifier(n_estimators=100, random_state=42)

# RFE برای انتخاب 2 ویژگی برتر

rfe = RFE(model, n_features_to_select=2)

X_rfe = rfe.fit_transform(X, y)

print("ویژگیهای منتخب با RFE:\n", X_rfe[:5])

توضیح:

- RFE (Recursive Feature Elimination) به صورت مکرر ویژگیهای کماهمیت را حذف میکند.

- نیاز به یک مدل پایه دارد که اهمیت ویژگیها را ارزیابی کند.

3. روشهای توکار (Embedded Methods)

from sklearn.linear_model import Lasso

from sklearn.preprocessing import StandardScaler

import numpy as np

# مقیاسبندی دادهها

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)

# مدل Lasso

lasso = Lasso(alpha=0.1)

lasso.fit(X_scaled, y)

# وزن ویژگیها

importance = np.abs(lasso.coef_)

selected_features = np.where(importance > 0)[0]

print("ویژگیهای منتخب با Lasso:\n", selected_features)

توضیح:

- Lasso با L1 Regularization ویژگیهای کماهمیت را به صفر میرساند.

- به طور همزمان ویژگیها و مدل را بهینه میکند.

مثال عملی روی دیتاست واقعی

فرض کنید دیتاست Titanic را داریم و میخواهیم ویژگیهای مهم برای پیشبینی بقا را انتخاب کنیم:

import pandas as pd

from sklearn.ensemble import RandomForestClassifier

from sklearn.feature_selection import SelectFromModel

# بارگذاری دیتاست Titanic

df = pd.read_csv("titanic.csv")

X = df.drop("Survived", axis=1)

y = df["Survived"]

# مدل RandomForest

model = RandomForestClassifier(n_estimators=100, random_state=42)

model.fit(X, y)

# انتخاب ویژگیهای مهم

selector = SelectFromModel(model, prefit=True)

X_selected = selector.transform(X)

print("ویژگیهای منتخب Titanic:\n", X_selected[:5])

توضیح:

- روش Embedded با RandomForest برای شناسایی ویژگیهای مهم استفاده شده است.

- ویژگیهای غیرمهم حذف شده و مدل سبکتر و سریعتر آموزش مییابد.

چالشها و راهکارهای انتخاب ویژگی

انتخاب ویژگی میتواند در عمل با چالشهایی روبرو شود. شناسایی این چالشها و دانستن راهکارهای مناسب، میتواند فرآیند مدلسازی را بهبود دهد. برای شروع یادگیری عملی و تمرین مهارتها، پیشنهاد میشود از آموزش هوش مصنوعی از صفر بهره ببرید تا با مفاهیم پایه و پیشرفته هوش مصنوعی آشنا شوید.

چالشها

- وجود ویژگیهای زیاد و پیچیده

- در دادههای با ابعاد بالا، بررسی تمام ترکیبهای ممکن ویژگیها دشوار و زمانبر است.

- ارتباط پیچیده بین ویژگیها و هدف

- بعضی ویژگیها به تنهایی کماهمیت به نظر میرسند اما در ترکیب با دیگر ویژگیها، اهمیت پیدا میکنند.

- عدم تعمیمپذیری مدل

- انتخاب ویژگی بیش از حد خاص میتواند باعث شود مدل روی دادههای جدید عملکرد ضعیفی داشته باشد (Overfitting).

- دادههای ناقص یا نویزی

- دادههای دارای نویز یا مقادیر گمشده میتوانند منجر به انتخاب ویژگی اشتباه شوند.

راهکارها

- ترکیب روشها

- استفاده از ترکیب Filter و Wrapper میتواند سرعت و دقت را همزمان افزایش دهد.

- مقیاسبندی و پاکسازی دادهها

- قبل از انتخاب ویژگی، دادهها را نرمالیزه و مقادیر گمشده را مدیریت کنید.

- استفاده از روشهای Embedded

- روشهای Embedded ویژگیها را همزمان با آموزش مدل انتخاب میکنند و تعاملات پیچیده را بهتر در نظر میگیرند.

- اعتبارسنجی متقابل (Cross-Validation)

- برای جلوگیری از Overfitting، انتخاب ویژگی را همراه با Cross-Validation انجام دهید.

جمعبندی

انتخاب ویژگی (Feature Selection) یکی از مراحل حیاتی در یادگیری ماشین و دادهکاوی است که نقش کلیدی در بهبود دقت، کاهش پیچیدگی و افزایش سرعت آموزش مدلها دارد. با استفاده از روشهای مناسب، میتوان ویژگیهای غیرمؤثر یا نویزی را حذف کرده و فقط آن دسته از ویژگیهایی را نگه داشت که بیشترین اطلاعات را درباره هدف مدل ارائه میکنند.

همچنین پیادهسازی عملی این روشها در پایتون با استفاده از Scikit-learn نشان داد که چگونه میتوان ویژگیهای مهم را در پروژههای واقعی شناسایی و مدلها را بهینه کرد. علاوه بر تمرین عملی، تسلط بر مفاهیم پایه و ریاضی مدلهای هوش مصنوعی ضروری است. منابعی مانند آموزش ریاضیات هوش مصنوعی میتوانند شما را در مسیر یادگیری عمیق و کاربردی همراهی کنند.

با وجود مزایا، انتخاب ویژگی چالشهایی نیز دارد؛ از جمله ابعاد بالا، دادههای نویزی و ارتباط پیچیده بین ویژگیها. استفاده از ترکیب روشها، پاکسازی دادهها و اعتبارسنجی متقابل، راهکارهایی برای کاهش این چالشها هستند.

در نهایت، برای دانشجویان و پژوهشگران حوزه دادهکاوی توصیه میشود که همزمان با یادگیری تئوری، پیادهسازی عملی را با دیتاستهای واقعی تمرین کنند تا مهارتهای عملی آنها در بهبود مدلهای پیشبینی تقویت شود.

انتخاب ویژگی یک مهارت کلیدی است که با به کارگیری درست آن، مدلهای هوشمند و قابل اعتمادتر ایجاد میشوند و مسیر توسعه پروژههای هوش مصنوعی و یادگیری ماشین را هموار میسازد.

برای دریافت راهنمایی تخصصی در انتخاب بهترین دوره آموزشی متناسب با نیازتان، کارشناسان آموزشی ما آماده پاسخگویی و مشاوره هستند. با شماره ۰۹۹۰۵۵۰۱۹۹۸ ارتباط بگیرید.

سوالات متداول

1-انتخاب ویژگی (Feature Selection) چه تفاوتی با کاهش ابعاد (Dimensionality Reduction) دارد؟

انتخاب ویژگی ویژگیهای موجود را نگه میدارد یا حذف میکند، اما کاهش ابعاد معمولاً ویژگیهای جدید ترکیبی میسازد (مثل PCA).

2-بهترین روش انتخاب ویژگی برای دادههای با ابعاد بالا کدام است؟

معمولاً ترکیبی از Filter Methods برای کاهش سریع ابعاد و Embedded Methods برای دقت بیشتر توصیه میشود.

3-آیا حذف ویژگیهای کماهمیت همیشه باعث افزایش دقت مدل میشود؟

خیر، حذف ویژگیها بدون تحلیل مناسب ممکن است اطلاعات مفیدی را از دست بدهد. بنابراین استفاده از روشهای معتبر و اعتبارسنجی مدل ضروری است.

4-چگونه میتوانم بهترین روش انتخاب ویژگی را برای پروژه خود انتخاب کنم؟

بستگی به اندازه داده، نوع مدل، منابع محاسباتی و دقت مورد انتظار دارد. میتوانید از کارشناسان ما مشورت بگیرید.